摘要

传统爬虫技术门槛高、维护成本大。2025年AI工具如Firecrawl、crawl4ai等,利用LLM理解网页结构,实现自然语言交互爬取,极大提升数据获取效率与适应性。

在业务实战中,做任何决策都需要有依据——这个依据又往往是基于数据分析出来的,而想要做数据分析的前提是「有数据」。

所以「爬取数据」(也叫爬虫)在任何时候都是一件很重要的事。

今天饼干哥哥就给大家介绍一下****爬虫这件事在 2025 年 AI 工具的加持下长什么样?

爬虫的逻辑

不论什么工具,爬虫的步骤是不变的:

-

请求网页: 使用 HTTP 库(如 Python 中的

requests)向目标网站发送请求,获取网页的 HTML 源代码。 -

解析内容: 利用 HTML/XML 解析库(如 Python 中的

BeautifulSoup或lxml)来解析源代码,定位到需要提取的数据元素。这通常依赖于 HTML 标签、CSS 选择器或 XPath 表达式。 -

提取数据: 从解析后的结构中提取所需信息,如文本、链接、图片地址等。

-

处理数据: 清洗、格式化提取到的数据,并将其存储到数据库、文件或其他存储介质中。

-

处理反爬机制: 开发者还需要应对网站的反爬虫措施,例如设置 User-Agent、处理 Cookies、使用代理 IP、识别并绕过验证码(CAPTCHA)、以及处理 JavaScript 动态加载的内容(可能需要用到

Selenium或Playwright等浏览器自动化工具)。

传统爬虫的痛点

由此,我们可以看出来天下苦爬虫久矣:

-

技术门槛高: 需要掌握编程语言、网络请求、HTML/CSS/XPath、数据库知识,甚至浏览器自动化技术。

-

维护成本高: 网站结构一旦改变,之前编写的解析规则(CSS 选择器、XPath)就可能失效,需要重新分析和修改代码。

-

反爬限制多: 网站的反爬策略越来越复杂,增加了爬取的难度和成本。

-

动态内容处理复杂: 对于大量使用 JavaScript 动态生成内容的网站(单页应用 SPA 等),传统方法处理起来比较麻烦。

AI 时代的爬虫:更智能、更简单

随着人工智能,特别是大型语言模型(LLM)的发展,网络爬虫领域也迎来了新的变革。AI 驱动的爬虫工具试图解决传统爬虫的痛点,利用 AI 的能力来理解网页结构、自动识别所需数据、甚至用自然语言交互来定义爬取任务。

甚至,可以一句话完成一个数据爬取的需求。

以下介绍四款在 2025 年值得关注的 AI 爬虫相关工具,并对比它们的特点和适用场景:

1. Firecrawl (https://github.com/mendableai/firecrawl)

一个“将任何网站转化为 LLM 就绪(LLM-ready)的干净 Markdown/结构化数据”的工具。它不仅能抓取单个页面,还能进行网站范围内的爬行,并将抓取到的内容处理成适合大型语言模型(如 GPT 系列、Claude 等)直接使用的格式。

-

核心特点:

- LLM 优化输出: 主要目标是输出干净、结构化的 Markdown 或 JSON 数据,移除了导航栏、页脚、广告等无关内容,非常适合 RAG (Retrieval-Augmented Generation) 等 LLM 应用场景。

- 抓取与爬行: 支持抓取单个 URL,也支持设定爬行深度和规则,对整个网站或特定路径下的页面进行爬取。

- API 优先: 提供简单的 API 接口,方便开发者集成到自己的应用程序中。

- 集成友好: 官方提供了与 LangChain、LlamaIndex 等流行 LLM 框架的集成示例。

-

适合应用的场景:

- 构建 RAG 系统: 需要将大量网页内容(如产品文档、博客文章、知识库)作为知识源输入给 LLM 时,Firecrawl 可以高效地抓取并清理这些数据。

- 内容摘要与分析: 快速抓取新闻、报告等网页,提取核心内容进行摘要或进一步分析。

- 竞品监控: 爬取竞争对手网站的产品介绍、价格、博客更新等,并转化为易于处理的格式。

-

目标用户与解决的问题:

- 什么样的人: 需要将网络内容整合到 AI 应用中的开发者、AI 工程师、数据科学家。

- 遇到了什么难题: 传统爬虫获取的数据杂乱,包含大量 HTML 标签和无关信息,需要花费大量精力进行清洗才能用于 LLM;或者需要爬取整个网站结构化信息。

- 用 Firecrawl 可以怎么样解决: 通过简单的 API 调用或库集成,直接获取经过 AI 处理的、干净的、LLM 友好的 Markdown 或结构化数据,极大简化了数据预处理流程,提高了开发效率。例如,一个团队想基于公司内部的 confluence 文档构建一个问答机器人,可以使用 Firecrawl 爬取所有文档页面,获得干净的文本数据,然后输入到 RAG 系统中。

2. crawl4ai (https://github.com/unclecode/crawl4ai)

核心理念是利用大型语言模型(LLM)来“理解”网页的结构,而不是依赖于固定的 CSS 选择器或 XPath。它旨在创建一个能适应各种网站布局变化的、更具鲁棒性的爬虫。

-

核心特点:

- LLM 驱动的结构理解: 不依赖硬编码的解析规则,而是让 LLM 分析页面内容和结构,推断出哪里是标题、哪里是正文、哪里是列表等。

- 潜在的鲁棒性: 理论上,即使网站的 HTML 结构发生变化,只要内容的语义结构没有大变,LLM 仍有可能正确提取信息,减少了维护成本。

- Python 库: 提供 Python 接口,方便在代码中集成和使用。

- 灵活性: 可以配置使用不同的 LLM 模型(如 GPT 系列、开源模型等)作为其“大脑”。

-

适合应用的场景:

- 爬取结构多变的网站: 对于那些频繁更新布局或没有统一模板的网站(如各种论坛、博客聚合页、小型电商网站),crawl4ai 提供了更高的适应性。

- 非结构化数据提取: 当需要提取的信息没有明确的 HTML 标签标识,但可以通过上下文理解时(例如,提取文章中的关键观点)。

- 快速原型验证: 在不确定网站结构或不想花时间分析 HTML 时,可以尝试使用 crawl4ai 进行快速的数据抓取。

-

目标用户与解决的问题:

- 什么样的人: 需要从各种结构不一的网站上持续抓取数据的开发者、数据分析师、研究人员。

- 遇到了什么难题: 维护传统爬虫成本高,网站一改版爬虫就失效;或者面对大量没有规范结构的网页,难以编写统一的解析规则。

- 用 crawl4ai 可以怎么样解决: 利用 LLM 的理解能力,使爬虫对网站布局变化的容忍度更高,减少因网站更新导致的爬虫失效问题。例如,一个市场分析师需要追踪多个行业新闻网站的最新报道标题和摘要,这些网站风格各异且可能改版,使用 crawl4ai 可以设置一个任务,让 LLM 自行判断并提取各个网站的“新闻标题”和“摘要”,适应性更强。

3. Jina AI Reader API (https://jina.ai/)

Jina AI 是一家提供多种 AI 基础设施和服务的公司。其 Reader API (可以通过

r.jina.ai/前缀访问) 提供了一种极其简单的方式来抓取网页内容。用户只需在目标 URL 前加上r.jina.ai/或s.jina.ai/(用于搜索结果抓取),即可通过 API 获取网页的干净内容(通常是 Markdown 格式)或结构化数据。

-

核心特点:

- 极简易用: 无需编写代码,只需修改 URL 即可发起请求,是目前接触到的最简单的网页抓取方式之一。

- 即时内容获取: 快速返回处理后的网页内容,适合需要快速获取单页信息的场景。

- 处理动态内容: Jina AI 的后端会自动处理 JavaScript 渲染等问题,用户无需关心。

- 多种输出: 除了返回干净的文本内容,也可能支持返回 JSON 格式的结构化数据(具体能力可能需查阅最新文档)。

-

适合应用的场景:

- 快速集成: 在任何支持 HTTP 请求的应用或脚本中快速嵌入网页抓取功能,如在 Slack Bot、快捷指令(Shortcuts)、甚至电子表格中直接调用。

- 无代码/低代码平台: 非常适合与 Zapier、Make 等自动化平台集成,实现网页内容的自动化流转。

- 简单内容预览/提取: 需要快速查看某个网页的主要内容,或者提取文章主体文本。

- 搜索引擎结果抓取:

s.jina.ai/前缀专门用于抓取搜索引擎结果页面(SERP)。

-

目标用户与解决的问题:

- 什么样的人: 需要快速、简单地获取网页内容的开发者、产品经理、市场人员、甚至普通用户;以及在无代码/低代码环境中工作的用户。

- 遇到了什么难题: 不想或没有时间编写爬虫代码;需要快速将网页内容整合到现有工具流中;需要处理 JS 渲染但不想配置复杂环境。

- 用 Jina AI Reader API 可以怎么样解决: 提供了一个几乎零门槛的网页抓取入口。例如,一个内容创作者想快速收集几篇关于某个主题的博客文章的主要内容,只需在浏览器地址栏或使用简单的

curl命令,在文章 URL 前加上r.jina.ai/,就能立即得到清理过的文本,方便后续整理和参考。

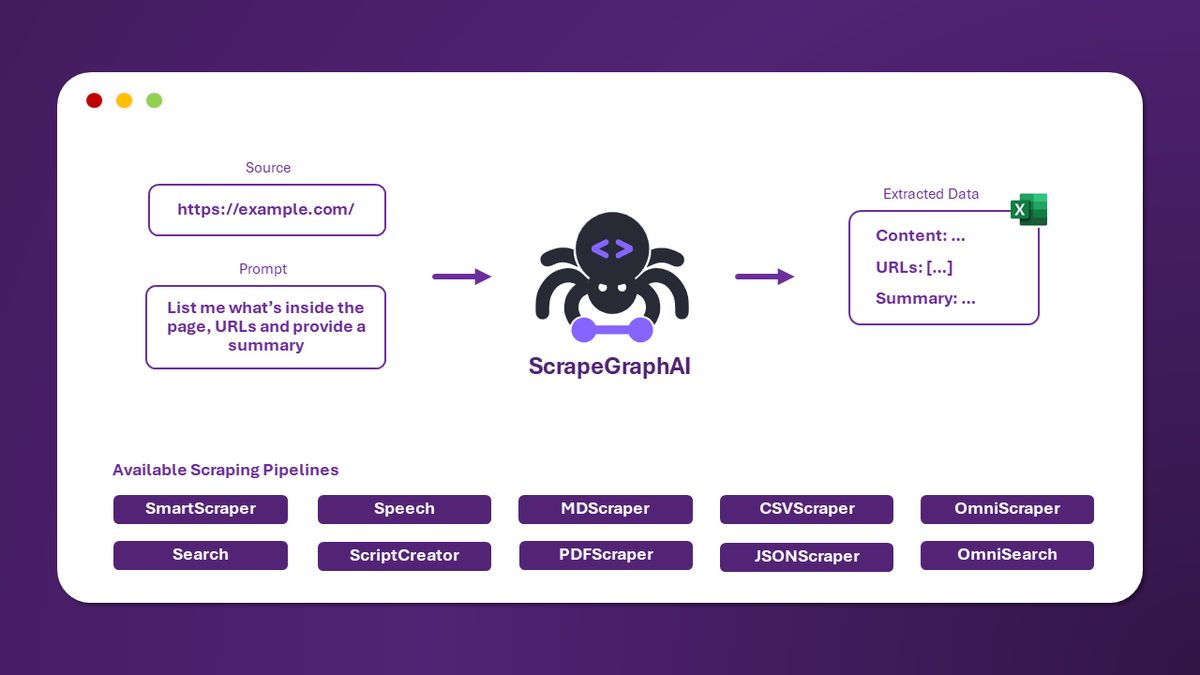

4. Scrapegraph-ai (https://github.com/ScrapeGraphAI/Scrapegraph-ai)

Scrapegraph-ai 是一个利用 LLM 和图(Graph)结构来执行网络爬取的 Python 库。它允许用户通过定义一个包含不同节点(如“抓取页面”、“生成抓取逻辑”、“解析数据”)的图来构建爬取流程,并可以利用 LLM 根据自然语言提示生成抓取逻辑。

-

核心特点:

- 图驱动流程: 将爬取任务分解为图形中的节点和边,使得复杂流程可视化和模块化。

- LLM 集成: 可以利用本地或远程的 LLM(如 OpenAI、Groq、Ollama 支持的模型)来理解用户需求(例如,通过自然语言描述要抓取什么数据)并生成相应的抓取代码或策略。

- 灵活性与可扩展性: Python 库的形式提供了高度的灵活性,用户可以自定义节点类型和图结构,以适应复杂的抓取任务。

- 支持本地模型: 允许使用本地运行的 LLM 模型,这对于数据隐私和成本控制非常重要。

-

适合应用的场景:

- 复杂抓取逻辑: 当爬取任务涉及多个步骤、条件判断或需要组合不同类型的数据时,图结构能清晰地表达这种逻辑。

- 自然语言驱动抓取: 用户可以通过自然语言描述需要从页面中提取哪些信息,让 LLM 辅助生成抓取规则。

- 研究与实验: 适合研究人员探索 LLM 在自动化网络爬虫任务中的应用潜力。

- 定制化爬取管道: 需要构建高度定制化的数据提取管道(Pipeline)的企业或开发者。

-

目标用户与解决的问题:

- 什么样的人: 需要处理复杂爬取任务、希望利用自然语言交互或对 AI 驱动的爬虫技术感兴趣的 Python 开发者、数据工程师、AI 研究员。

- 遇到了什么难题: 传统爬虫难以处理需要复杂逻辑判断的抓取任务;希望用更自然的方式定义爬取目标;需要在保护数据隐私的前提下使用 LLM 进行爬取。

- 用 Scrapegraph-ai 可以怎么样解决: 提供了一个基于图和 LLM 的框架来构建和管理复杂的爬取工作流。例如,一位金融分析师需要从多个财经网站抓取特定公司的股价、最新新闻标题和相关评论摘要。他可以使用 Scrapegraph-ai 定义一个图:节点 1(抓取主要页面)、节点 2(使用 LLM 识别股价区域并提取)、节点 3(使用 LLM 识别新闻列表并提取标题)、节点 4(抓取评论区并用 LLM 进行摘要)、节点 5(合并结果)。他甚至可以用自然语言提示节点 2:“从页面中提取当前股价”。通过配置使用本地 LLM,可以确保处理过程的数据安全。

工具对比总结

| **特性** | **Firecrawl** | **crawl4ai** | **Jina AI Reader API** | **Scrapegraph-ai** |

| **核心技术** | 网页清理与转换 | LLM理解页面结构 | 网页内容提取服务 (可能含AI) | LLM + 图驱动的爬取流程 |

| **主要形式** | API, Python/JS库 | Python库 | URL前缀 API | Python库 |

| **易用性** | 简单 (API调用) | 中等 (需要Python编程) | 极简 (修改URL即可) | 中等偏高 (需要理解图和Python) |

| **输出格式** | LLM友好的Markdown/JSON | 结构化数据 (由LLM推断) | 干净文本/Markdown/JSON | 结构化数据 (按图定义) |

| **对动态内容** | 后端处理 | 依赖LLM分析渲染后DOM (可能) | 后端处理 | 依赖底层抓取节点 (如Playwright) |

| **鲁棒性** | 良好 (侧重内容清理) | 理论上高 (适应结构变化) | 良好 (服务方维护) | 中等 (图逻辑固定,LLM部分可能适应) |

| **主要优势** | 快速获取LLM就绪数据, 爬行能力 | 适应网站布局变化, 少规则维护 | 极致简单, 无代码集成友好 | 复杂流程定义, 自然语言交互, 本地LLM |

| **适合场景** | RAG数据准备, 内容分析 | 多变网站数据提取, 长期监控 | 快速单页抓取, 简单集成, 原型 | 复杂爬取管道, 研究, 定制化任务 |

| **目标用户** | AI开发者, 数据科学家 | 开发者, 数据分析师, 研究人员 | 所有人, 低代码/无代码用户 | Python开发者, 数据工程师, AI研究员 |

根据以上表格,大家可以基于实际需求,挑选合适的工具:

-

如果你需要为 LLM 应用(如 RAG)快速准备大量干净的网页数据,Firecrawl 是个不错的选择。

-

如果你需要爬取的网站结构经常变化,或者不想花太多时间维护 CSS 选择器,可以尝试 crawl4ai 。

-

如果你需要最简单快捷的方式获取单个网页内容,或者想在无代码平台中使用爬虫,Jina AI Reader API 无疑非常方便。

-

如果你的爬取任务逻辑复杂,或者希望用自然语言定义抓取目标,并且不介意编写 Python 代码,Scrapegraph-ai 提供了强大的灵活性和控制力。