摘要

出海业务流量获取难?本文教你用n8n搭建SEO内容引擎,自动分析竞品、生成优化文章并存入飞书,解决内容营销低效痛点,实现规模化精准流量增长。

初级:我用 n8ns 搭了个「SEO 内容引擎」,解决出海流量难题

如果你正在运营出海业务,例如跨境电商、独立站或 SaaS 软件,你会面临一个核心问题:如何有效获取海外精准流量。

你可能已经投入资源进行内容营销,撰写了多篇英文博客以吸引潜在客户。但实际结果可能是,大部分文章没有获得好的排名,导致投入产出比很低,并陷入了低效的重复工作。

这种缺乏明确方向的感觉很常见。我们花费精力创作的内容,常因未能充分分析并超越竞争对手,导致在搜索引擎的排名竞争中未能获得好的排名。

本文将搭建一个 n8n 自动化工作流,该工作流可以针对任何给定的关键词,自动完成以下任务:

-

识别 Top 3 竞品:在 Google 进行搜索,找出排名前三的竞争对手。

-

获取内容:抓取这三篇文章的全文内容。

-

分析与写作:将竞品内容提交给大型语言模型(AI),让它分析、整合并创作一篇全新的优化文章。

-

自动存储:将生成的内容自动存入你的飞书多维表格。

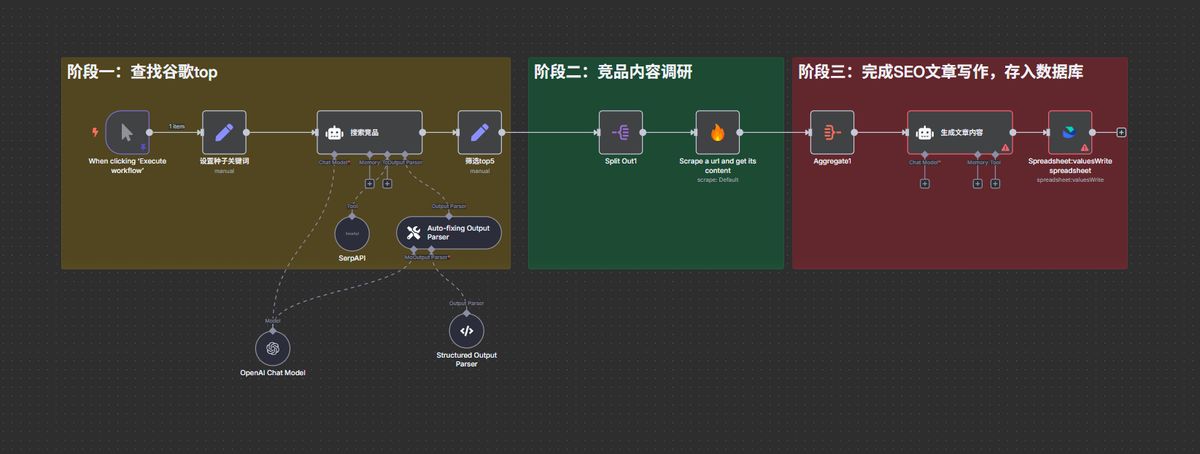

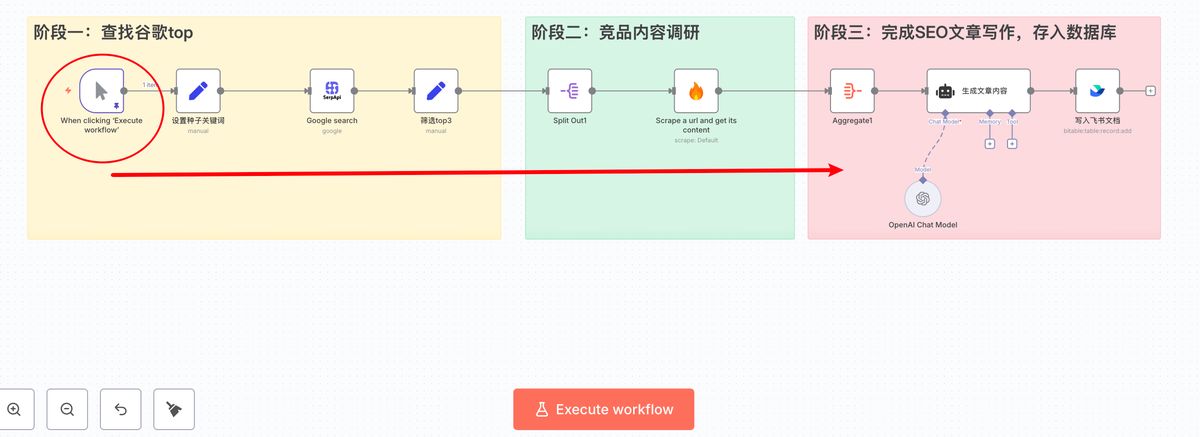

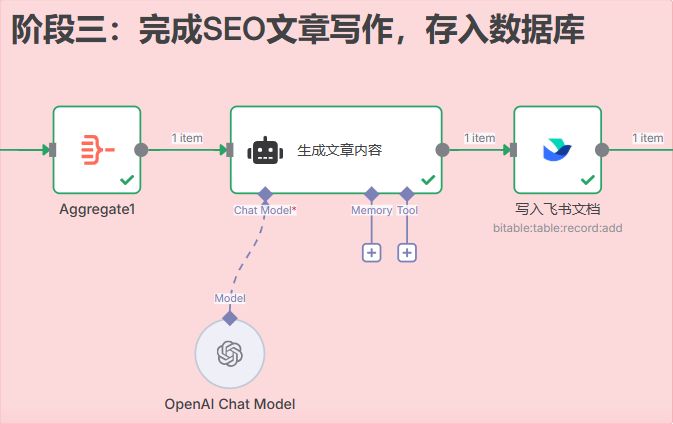

下图是该自动化工作流的结构示意,它分为三个主要阶段:谷歌 Top 调研 -> 竞品内容分析 -> SEO 文章生成与入库。

这个系统背后是一套严谨且高效的 SEO 执行逻辑。下面我们开始详细介绍。

一、一个有效的 SEO 执行框架

在配置 n8n 工作流之前,我们先明确该方法背后的逻辑,以及它解决了传统 SEO 内容生产流程中的哪些问题。

传统的手动内容生产模式

通常,在确定一个关键词后,流程如下:

-

调研:在 Google 中搜索关键词,手动打开排名前几的竞品文章。

-

分析:逐篇阅读,将标题结构、核心要点复制到文档中,试图找出它们的共同点和各自的特点。

-

写作:基于分析结果,重新组织语言,撰写一篇文章,并希望能写得比竞争对手更好。

-

发布:将文章发布到网站,然后等待搜索引擎收录和排名。

这个流程的主要问题是:效率低、依赖主观判断,并且难以规模化。

手动分析几篇文章非常耗时,且分析结果的客观性和全面性难以保证。此外,许多网站设置了反抓取机制,导致无法顺利复制全文内容。

AI 工作流解决方案

我们介绍的“SEO 内容引擎”旨在解决这些问题。它将重复性的数据采集和分析工作,交由 AI 和自动化工具处理。

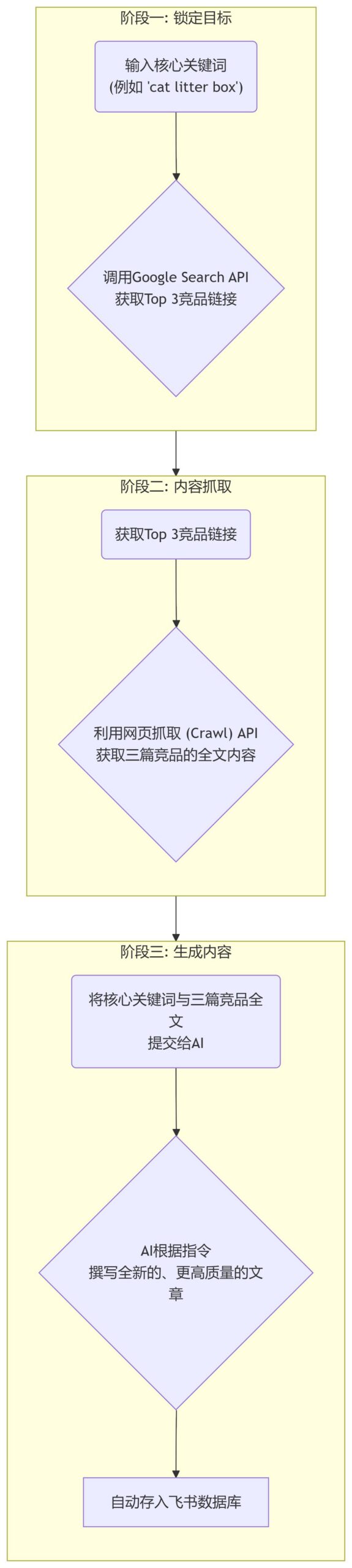

该框架分为三个步骤:

下面,我们进入实际操作环节,了解这个工作流在 n8n 中的具体搭建步骤。

二、详细教程:从 0 到 1 搭建“SEO 内容引擎”

我们将逐一介绍 JSON 文件中每个节点的配置和作用。

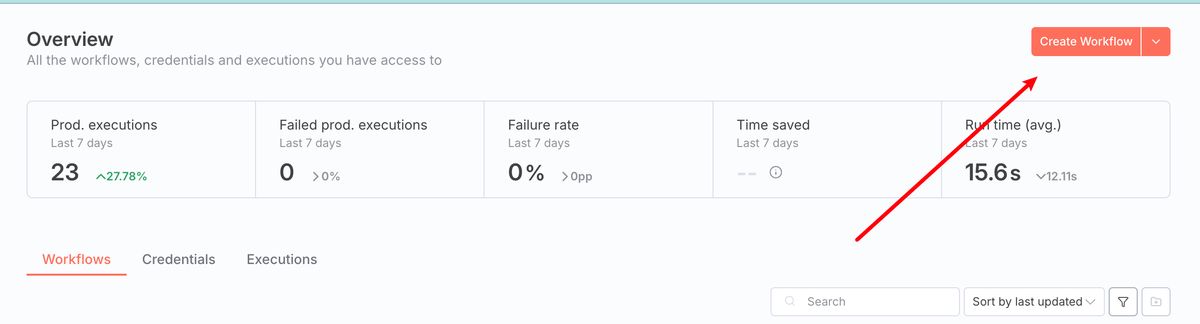

首先,先建一个工作流:

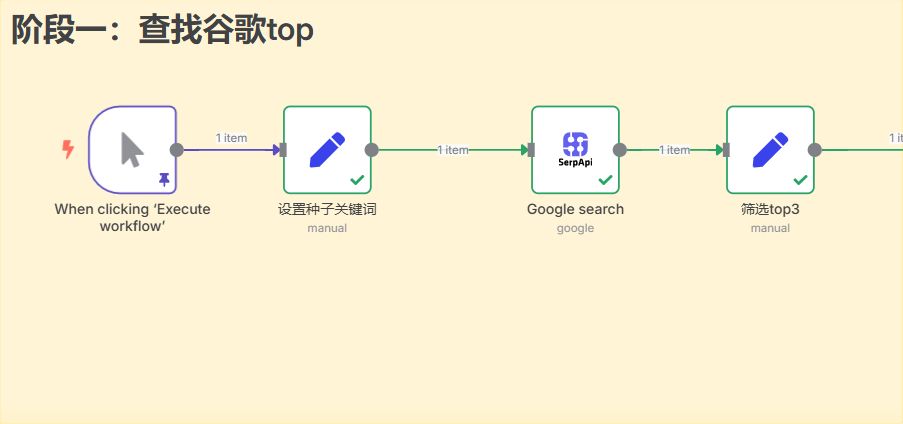

阶段一:查找谷歌 Top 3 竞品

此阶段的目标是,根据一个“种子关键词”,自动获取 Google 搜索结果中排名前三的自然结果。

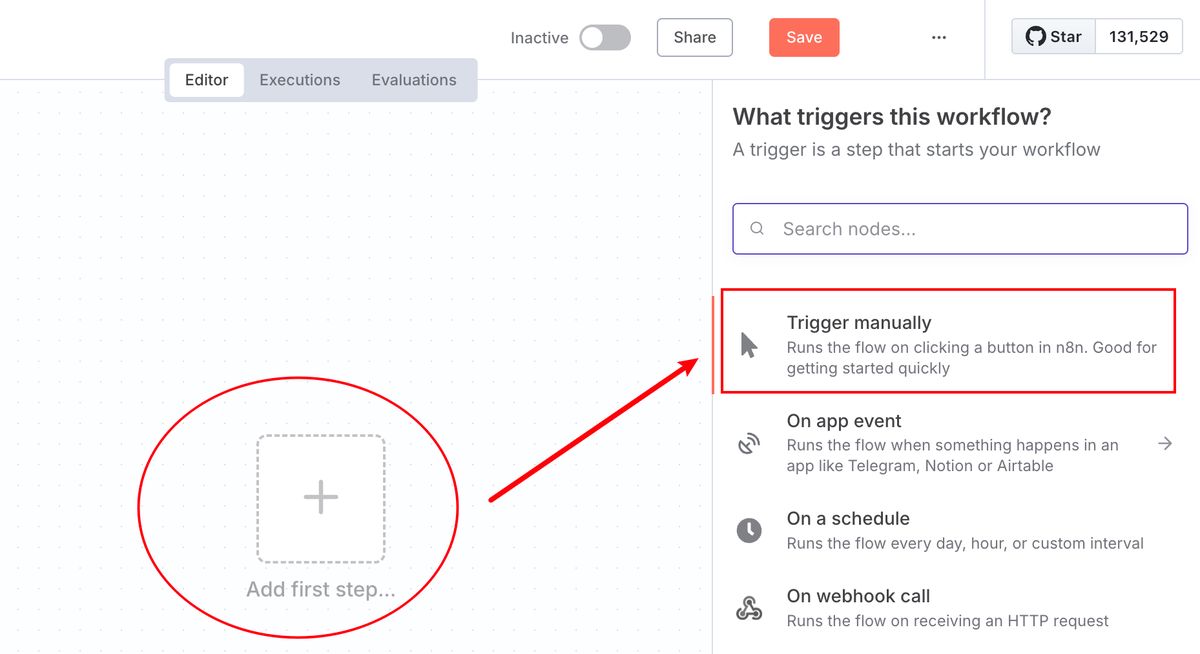

节点 1:When clicking ‘Execute workflow’ (Manual Trigger)

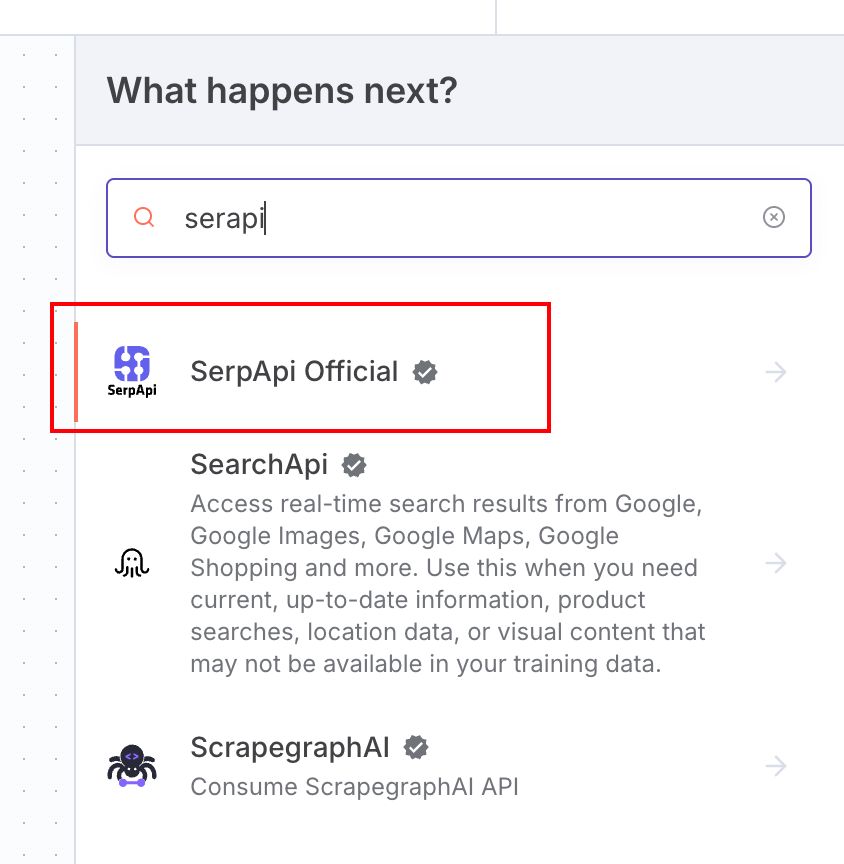

刚开始的时候啥都没有,点中间的 Add first step,右边就会弹出一个节点 nodes 的搜索框

第一个 Trigger Manually 就是我们要找到的「手动启动器」

**Trigger **的作用是,作为工作流开始的入口,当点击“Execute Workflow”后,流程就会从这里开始执行。

当然,这是其中的一种 Trigger,随着 n8n 深入的学习就会遇到更多不同的 Trigger

节点 2:设置种子关键词 (Set)

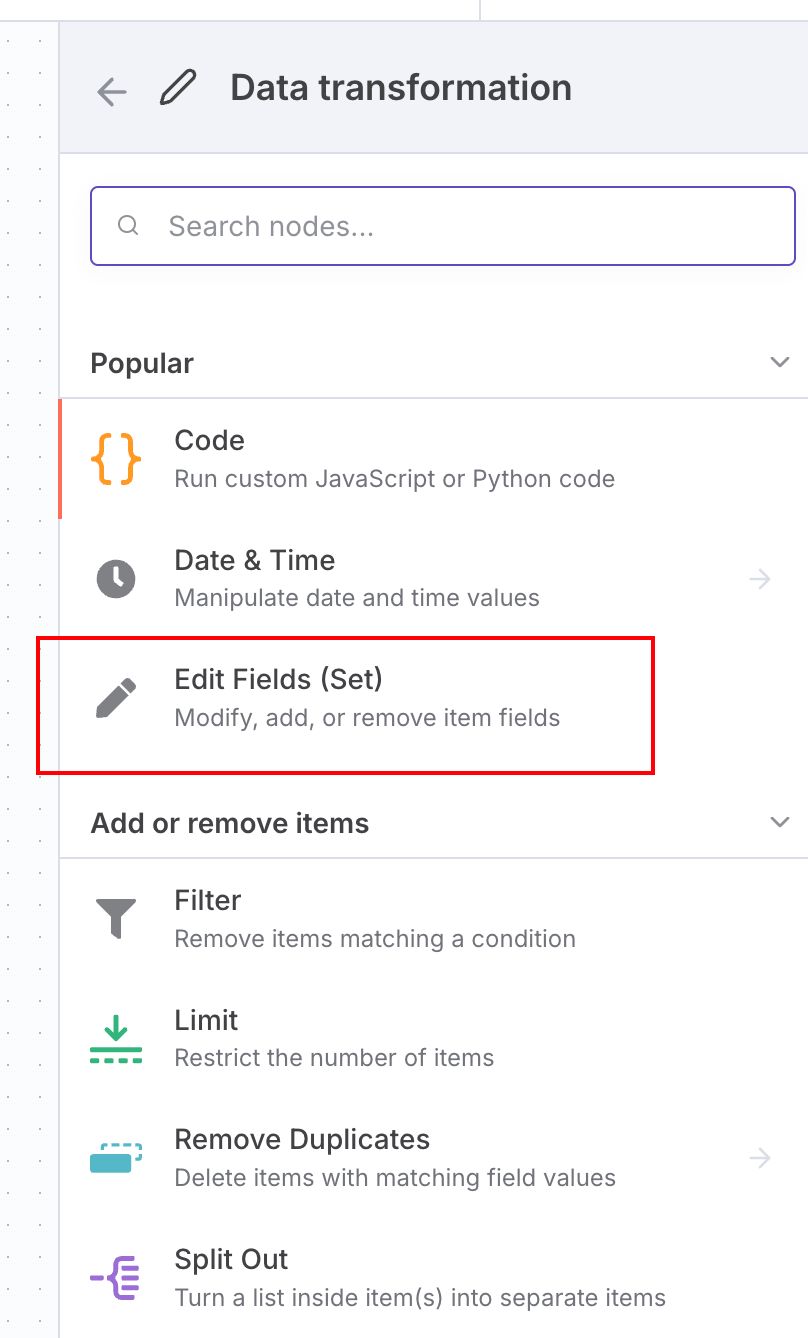

接下来要添加下一步的节点

点如图的 +,右边就会弹出来 what happens next 的窗口

里面同样是所有节点的合集

我们选 Data transformation

选择 Edit Fields(Set)

这是用于定义变量的。

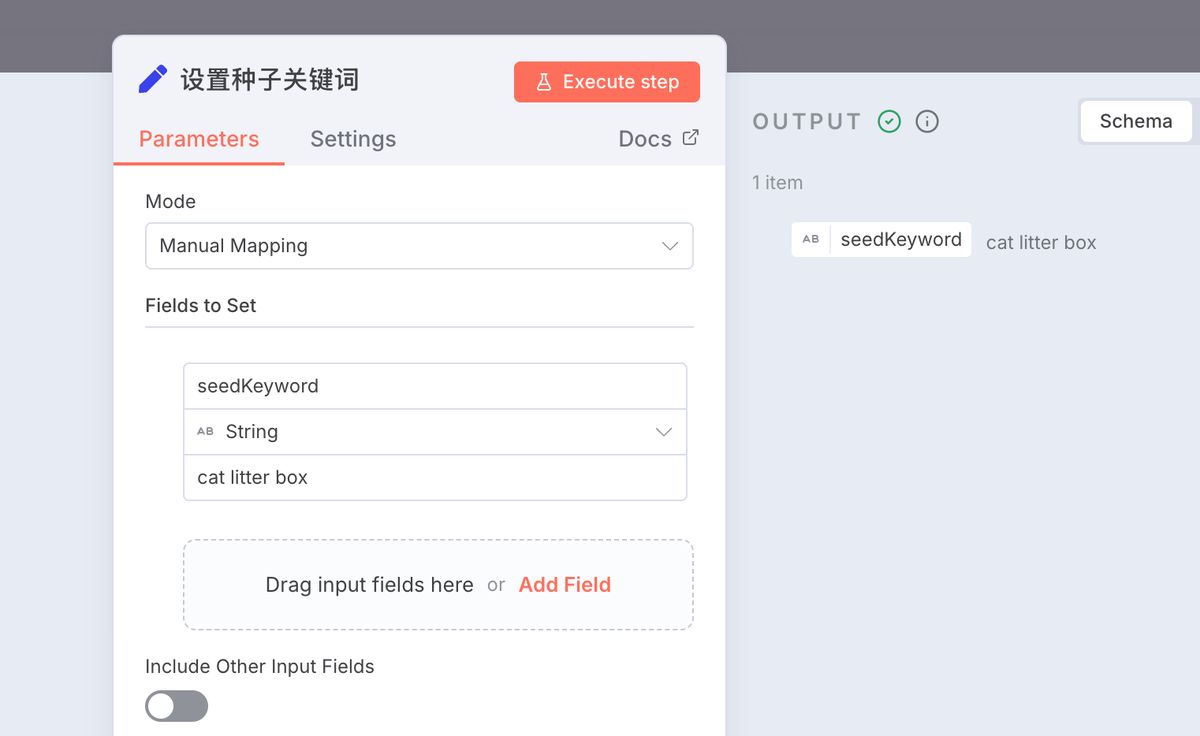

-

作用:定义需要分析的核心关键词,作为整个流程的输入。

-

配置:

- 在

Name字段中输入seedKeyword。 - 在

Value字段中输入目标关键词,例如:cat litter box。

- 在

确保跟图片一样的配置即可。

节点 3:Google search (SerpApi)

跟前面一样的方式,搜索 serapi,这是第三方通过谷歌接口搜索的工具。

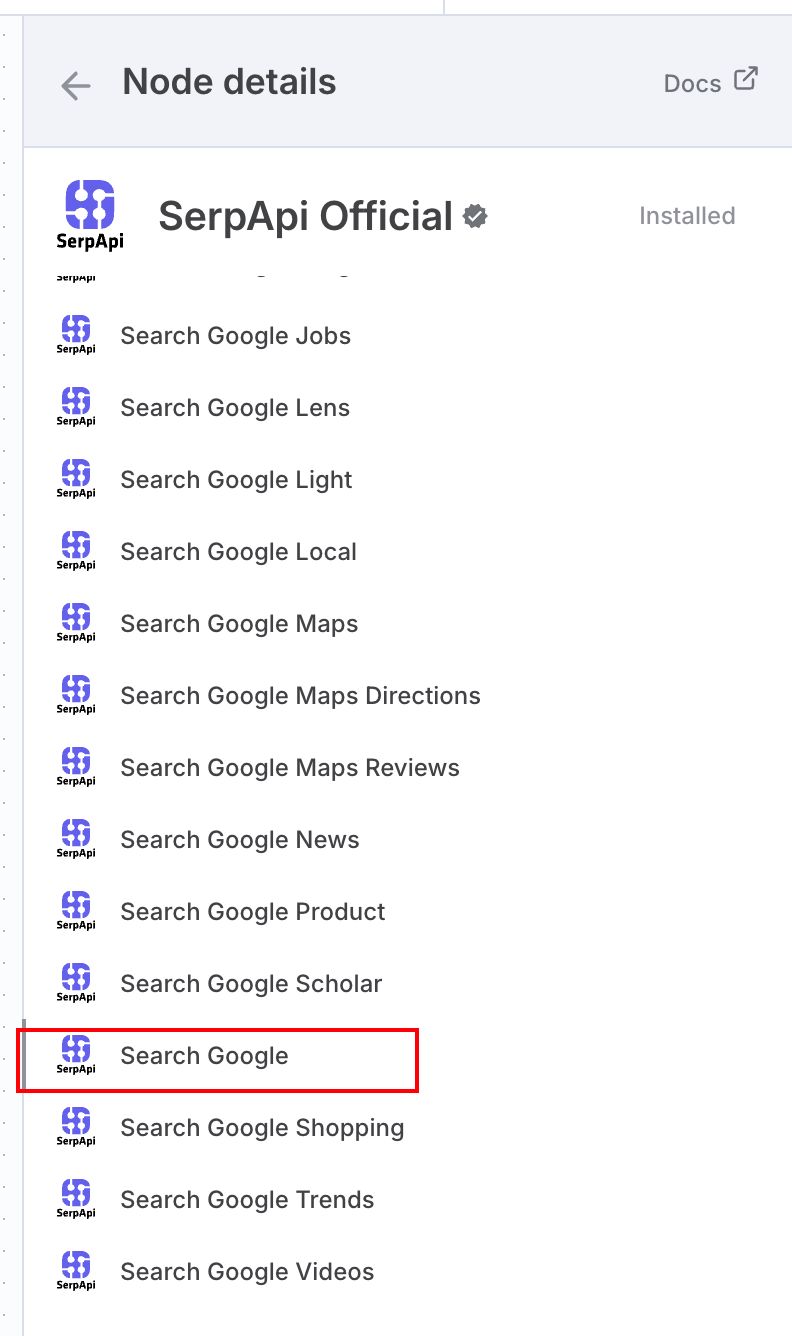

接着选择 Google Search 的功能节点即可

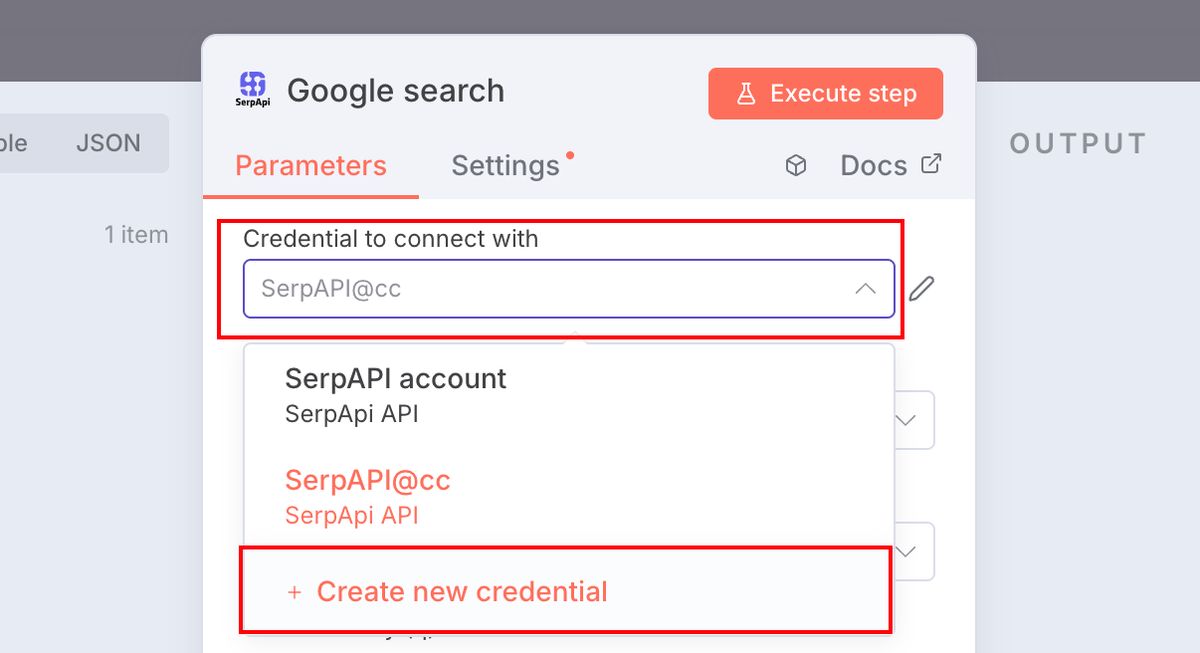

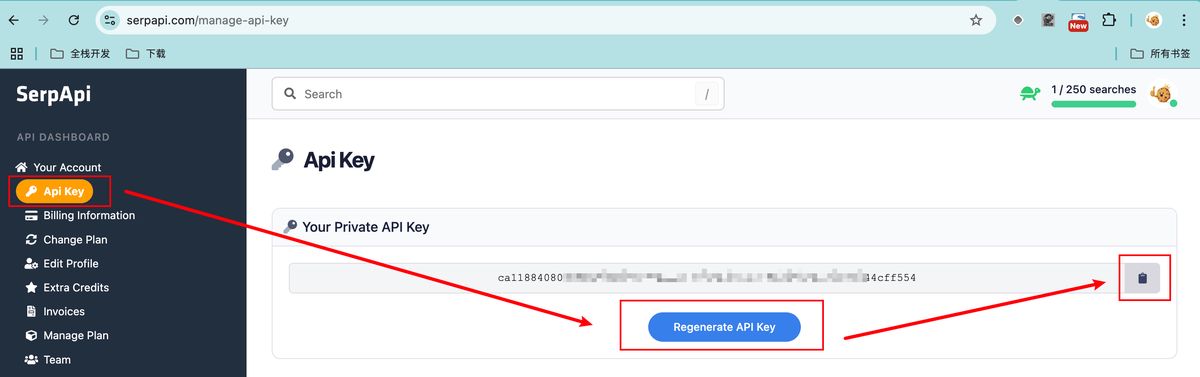

使用这种第三方 API 服务的,都需要事先创建一个密钥 credential

在如下图的位置

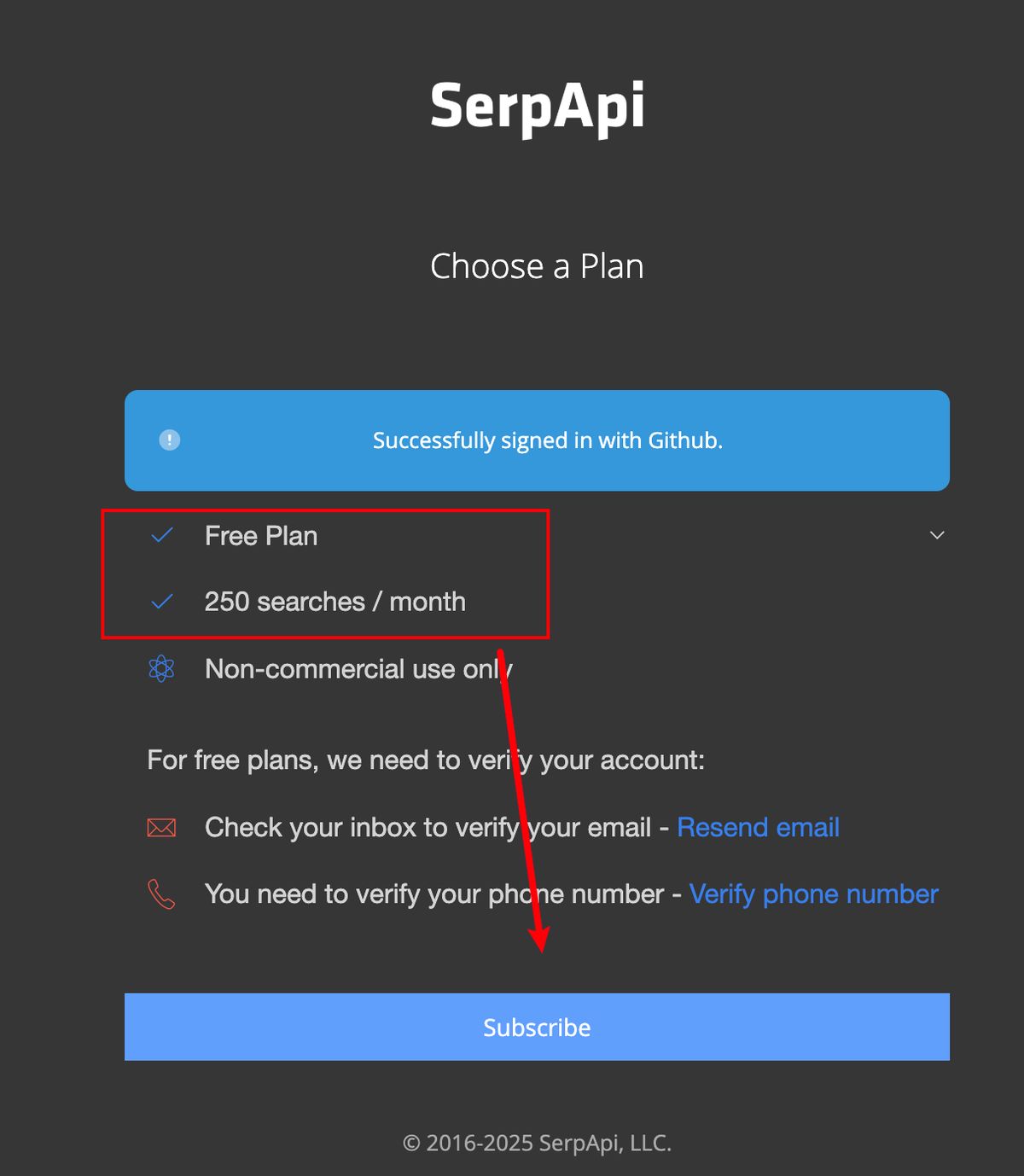

需要先访问以下地址,先注册一个账号

https://serpapi.com/users/sign_up

选择免费计划即可,每个月都可以免费执行 250 次搜索

注意要先验证邮箱和手机号

接着进入密钥管理的页面,新建一个 API Key,复制

https://serpapi.com/manage-api-key

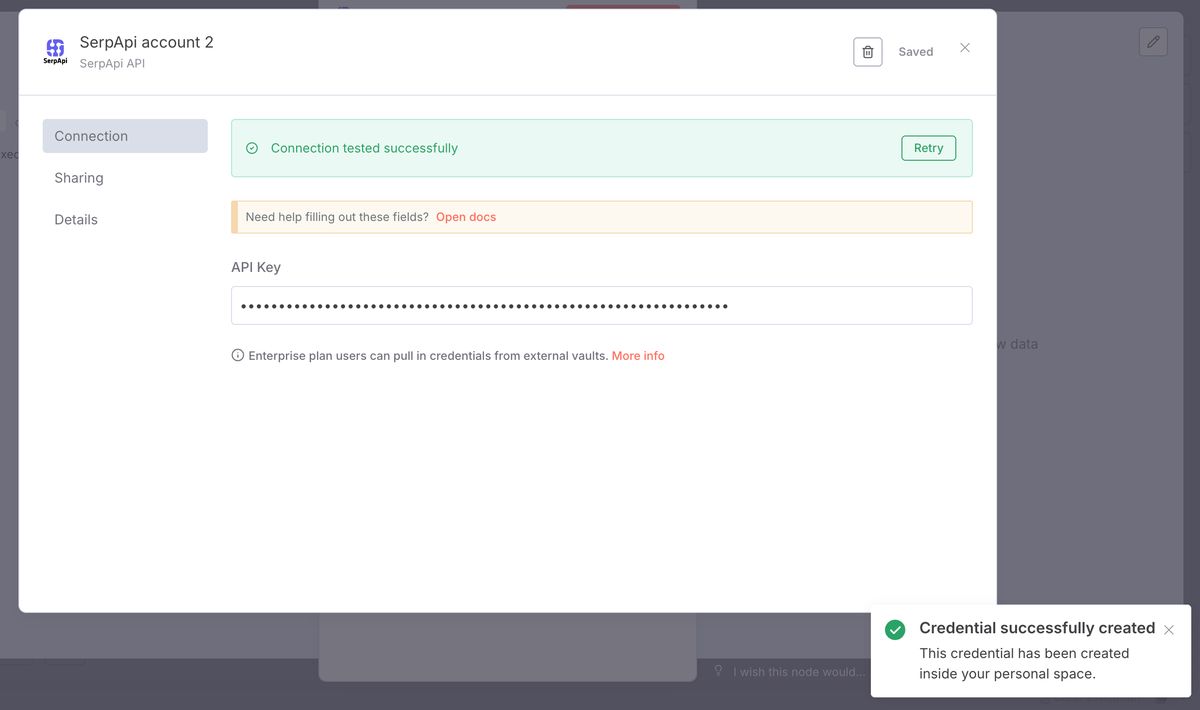

此时就可以回到 n8n 刚才创建 credential 的界面了

把密钥填进去,点 save,确保出现下图的验证成功的提示即可

此时就可以来做具体的配置了

-

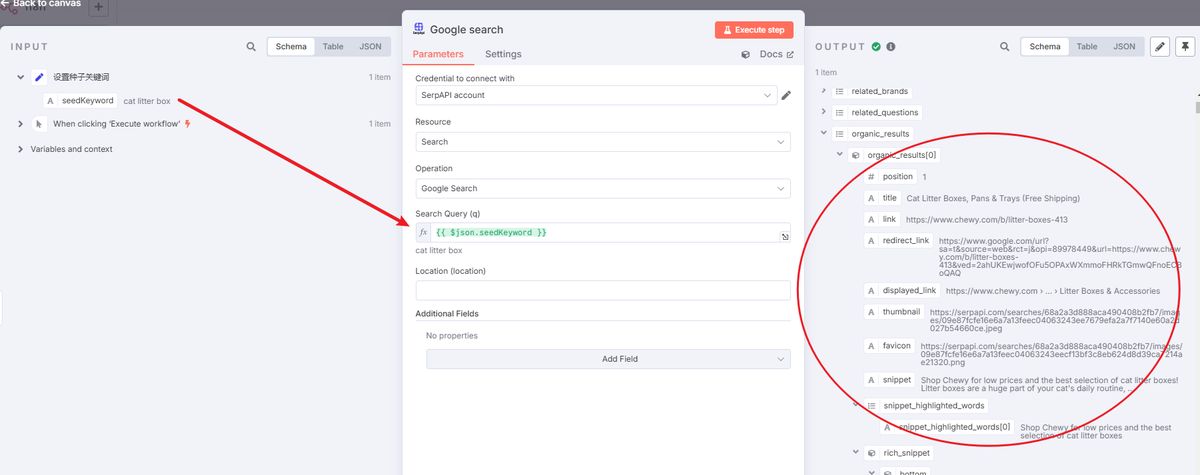

作用:使用设定的种子关键词,模拟 Google 搜索并返回搜索结果页的结构化数据。

-

配置:

- Credentials: 需要一个 SerpApi 账户及 API Key。在 n8n 中为 SerpApi 新建一个凭证。

- Query (q): 填入上一步设置的变量

{{ $('设置种子关键词').item.json.seedKeyword }}。

确保如图所示,测试下来右边输出结果有 organic_results,这些是谷歌查询的结果

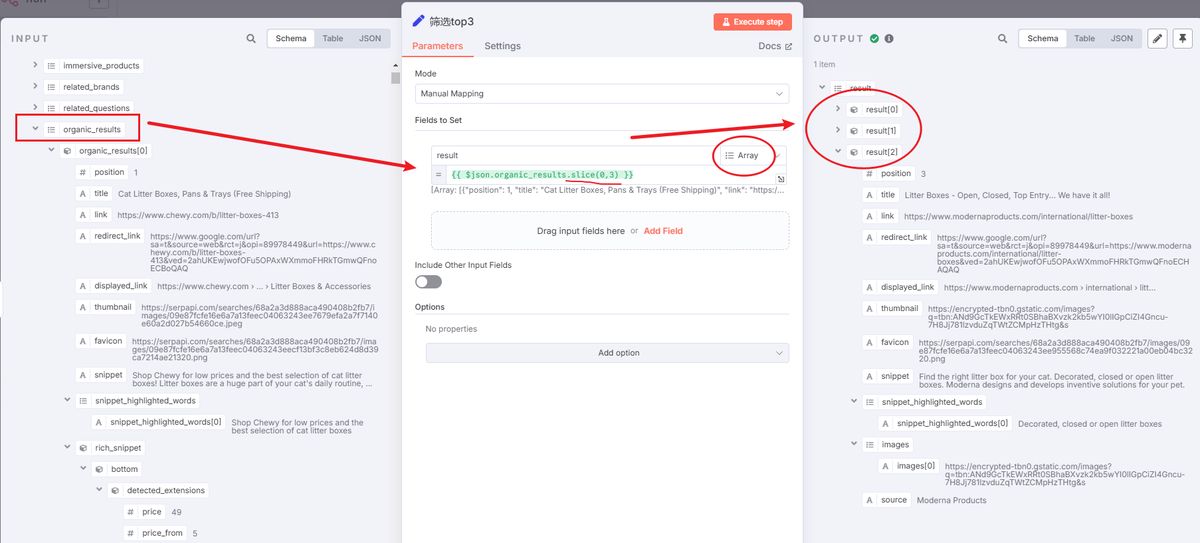

节点 4:筛选 top3 (Set)

-

作用:SerpApi 返回的数据包含广告、相关问题等多种类型。此节点用于筛选出仅我们需要的排名前三的自然搜索结果。

-

配置:

- 在

Name字段中输入result。 - 在

Value字段中输入表达式:{{ $json.organic_results.slice(0,3) }},该表达式用于提取自然搜索结果(organic_results)的前三个条目。 - 注意类型这里一定是 Array****确保结果是数组类型,后续才可以正常拆分成多条内容

- 在

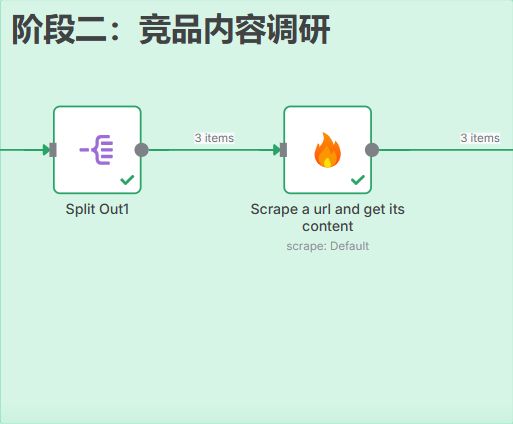

阶段二:竞品内容调研

获取 Top 3 竞品的 URL 后,下一步是抓取它们的完整内容。

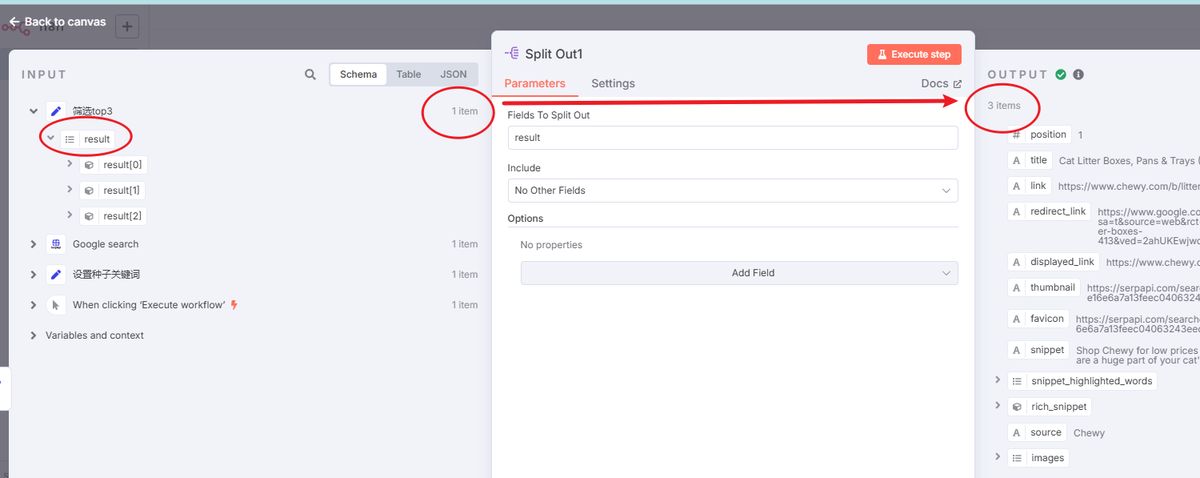

节点 5:Split Out1 (Split Out)

-

作用:上一步得到的是一个包含三个链接的列表。此节点将列表拆分为三个独立的条目,以便逐一处理每个链接。

-

配置:

- Field to Split Out: 填写

result,即上一个节点定义的变量名。

- Field to Split Out: 填写

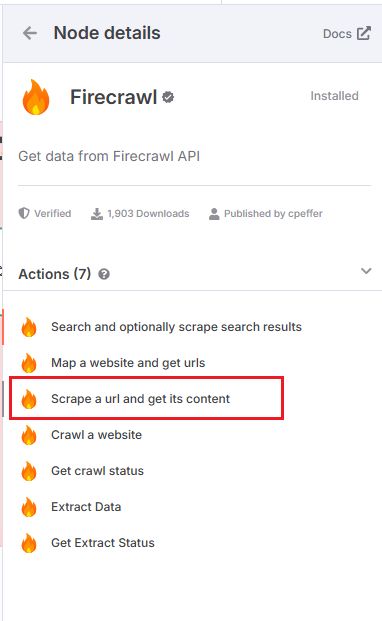

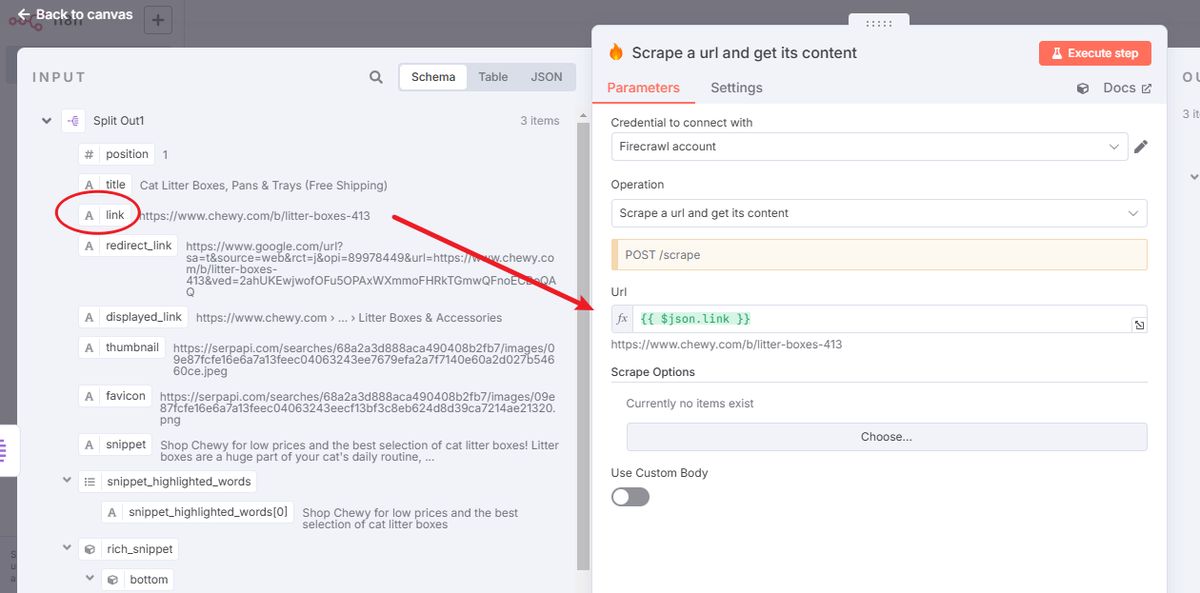

节点 6:Scrape a url and get its content (Firecrawl)

先搜索 firecrawl 提前安装好节点,然后选 Scrape a url and get its content

接着就是设置:

-

作用:这是工作流中的一个关键节点。它会访问每个竞品的 URL,并提取页面的核心正文,以 Markdown 格式返回。这解决了手动复制效率低和可能被反抓取机制阻止的问题。

-

配置:

- Credentials: 需要一个 Firecrawl 账户及 API Key。在 n8n 中为 Firecrawl 新建一个凭证。

- Operation: 保持默认的

scrape。 - URL: 填入从 Split Out 节点传递过来的竞品链接

{{ $json.link }}。

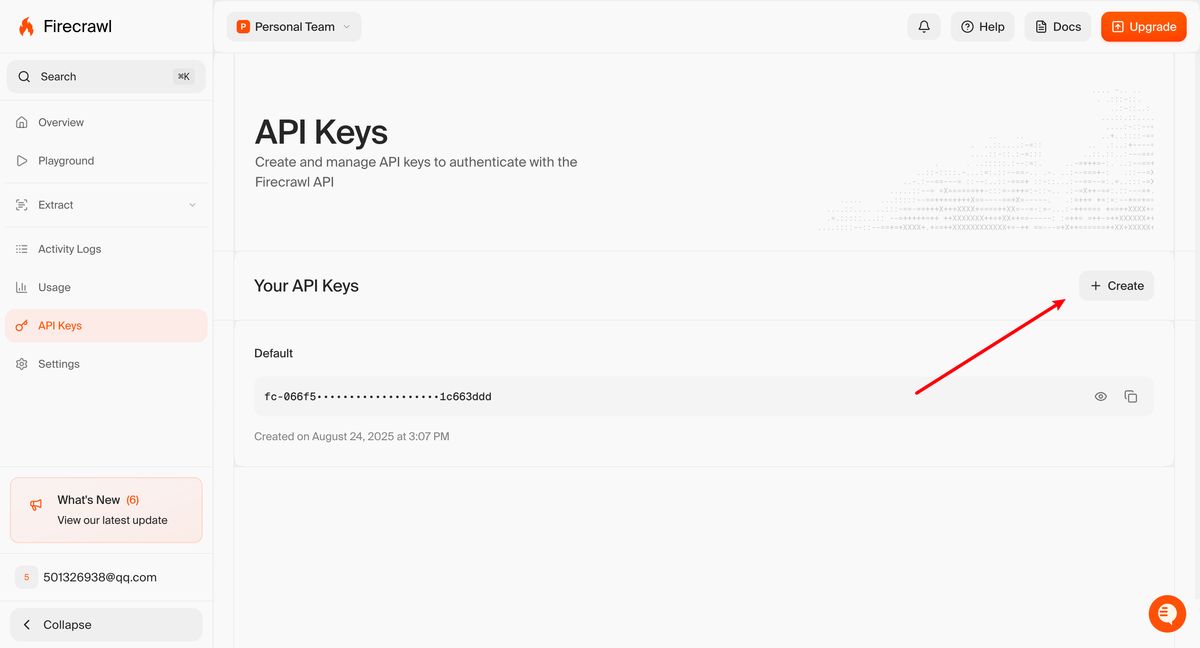

其中,Firecrawl 的 key 获取,补充说明一下:

要到官网注册:https://www.firecrawl.dev/signin

注册后到 api keys 管理:https://www.firecrawl.dev/app/api-keys

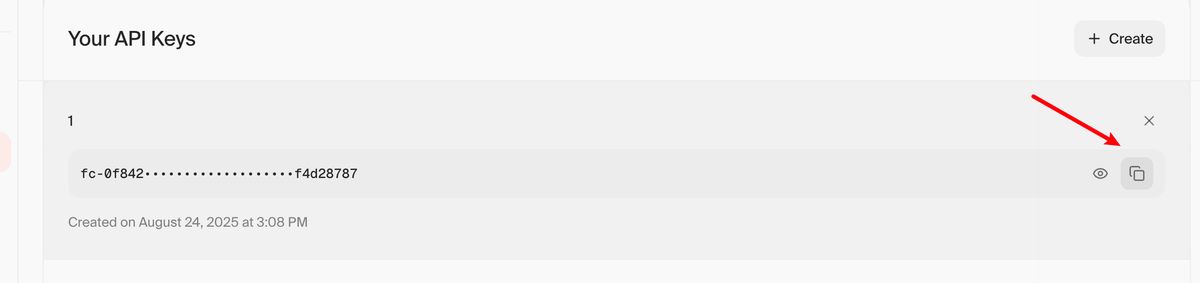

点 Create ,随便填入个名字即可

直接复制

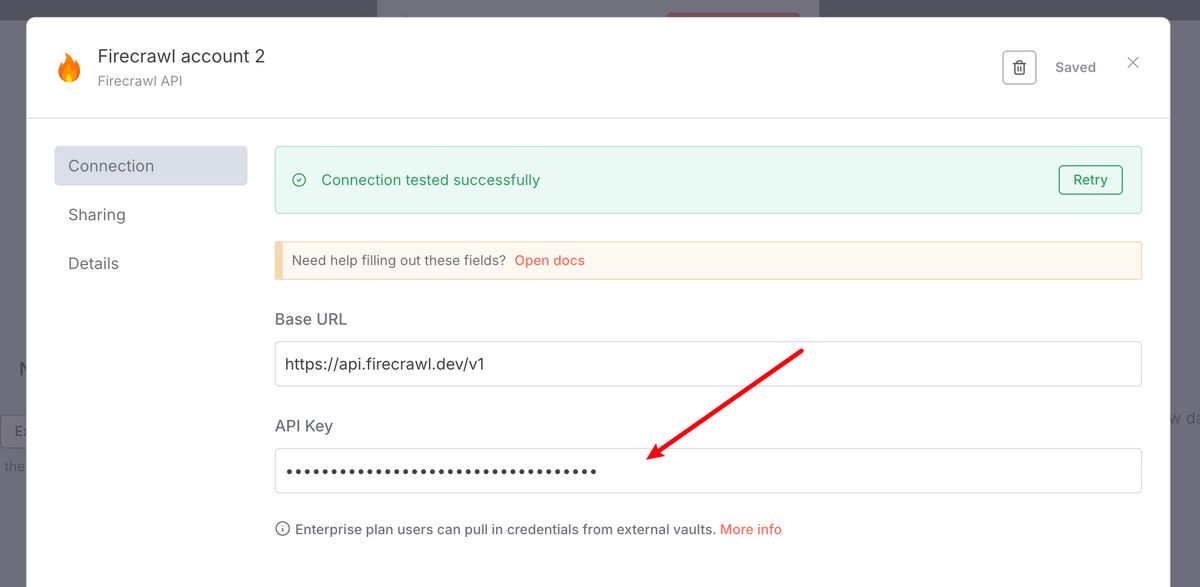

回到 n8n 节点中,创建 credential 的时候填入即可

阶段三:完成 SEO 文章写作,存入数据库

准备工作完成后,我们将所有收集到的信息提交给 AI,由它完成最终的写作任务。

节点 7:Aggregate1 (Aggregate)

-

作用:在处理完三个竞品链接后,我们得到三份独立的 Markdown 内容。此节点将这三份内容重新合并到一个数据项中,以便后续提交给 AI 模型。

-

配置:

- 在

Fields to Aggregate下,将Field to Aggregate设置为data.markdown。

- 在

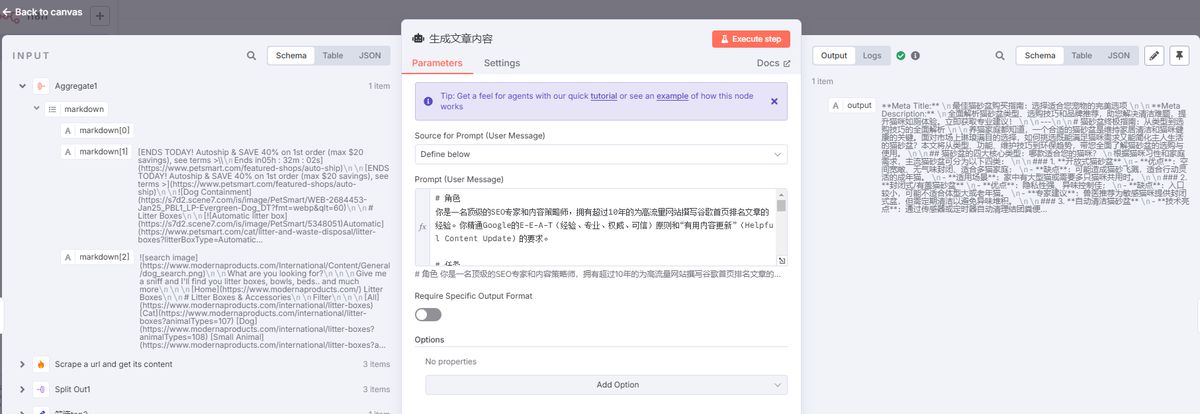

节点 8:生成文章内容 (Agent)

-

作用:作为“AI 写手”,该节点接收包含核心关键词和三篇竞品全文的信息,并根据预设指令撰写一篇全新的文章。

-

配置:

- 将此节点连接到

OpenAI Chat Model节点(或你选择的其他语言模型)。 - 在

Prompt区域,输入以下提示词。这是工作流的核心部分,用于指导 AI 的分析和创作过程。

- 将此节点连接到

=# 角色

你是一名顶级的SEO专家和内容策略师,拥有超过10年的为高流量网站撰写谷歌首页排名文章的经验。你精通Google的E-E-A-T(经验、专业、权威、可信)原则和“有用内容更新”(Helpful Content Update)的要求。

# 任务

你的核心任务是根据用户提供的【核心关键词】和三篇【参考文章】的内容,撰写一篇全新的、更高质量、更全面、对用户更有价值的SEO优化博客文章。最终目标是让这篇文章能够超越参考文章,在谷歌搜索结果中获得更好的排名。

# 核心原则

1. **分析与整合,而非抄袭与改写**:你的价值在于深入分析三篇参考文章的优点、共同点和缺失点,然后创造性地整合信息,并补充新的价值,而不是简单地拼接或同义词替换。

2. **满足搜索意图(Search Intent)**:首先判断【核心关键词】背后的用户意图(是想了解信息、解决问题、还是想购买产品?),确保你的文章内容完全围绕这个意图展开。

3. **提供独特价值**:思考如何让你的文章比参考文章更好。例如:提供更详细的步骤、加入最新的数据或案例、总结一个独特的框架、或者用更清晰易懂的方式解释复杂概念。

4. **遵循 E-E-A-T**:在写作时,要体现出专业性、权威性和可信度。如果可能,可以引用数据来源或专家观点(即使是基于参考文章的内容)。

# 输入数据

- **核心关键词**: {{ $('设置种子关键词').item.json.seedKeyword }}

- **参考文章1 (内容)**: {{ $json.markdown[0] }}

- **参考文章2 (内容)**: {{ $json.markdown[1] }}

- **参考文章3 (内容)**: {{ $json.markdown[2] }}

# 执行步骤

1. **深度分析**:仔细阅读并理解三篇【参考文章】。识别出它们共同涵盖的核心主题、子主题、关键论点和数据。同时,找出每篇文章的独特之处以及它们可能忽略的要点。

2. **规划大纲**:基于你的分析,设计一个全新的、逻辑清晰的文章大纲(包括H2、H3标题)。这个大纲应该比任何一篇参考文章都更全面、结构更合理。

3. **内容撰写**:根据你设计的大纲开始写作。使用通俗易懂、引人入胜的语言。确保文章的流畅性和可读性。

# 输出要求与格式

请严格按照以下格式输出,不要有任何额外的对话或解释。

**Meta Title:**

[在这里生成一个吸引眼球且包含【核心关键词】的标题,长度在60个字符以内]

**Meta Description:**

[在这里生成一段引人入胜的元描述,长度在150个字符以内,包含【核心关键词】并有明确的点击诱因]

---

# {文章标题 H1,必须包含核心关键词}

{引言部分:用1-3段话,快速抓住读者注意力,点明文章将要解决的核心问题或提供的主要价值,并自然地融入【核心关键词】。}

## {第一个H2子标题}

{围绕这个子标题展开详细论述。段落要简短,易于阅读。可以适当使用**加粗**来强调重点。}

### {H3子标题,可选}

{对H2主题下的某个要点做进一步的细分和解释。}

## {第二个H2子标题}

{继续展开论述。如果适合,可以使用项目符号列表(bullet points)或编号列表(numbered lists)来组织信息,让内容更清晰。}

* 要点一

* 要点二

* 要点三

## {可以包含“常见问题解答”或“总结”的H2标题}

{例如:关于{核心关键词}的常见问题 or 总结}

**1. 问题一?**

答案...

**2. 问题二?**

答案...

## 结论

{在文章末尾进行总结,重申核心观点,并给读者一个明确的行动号召(Call to Action)或最终的建议。}

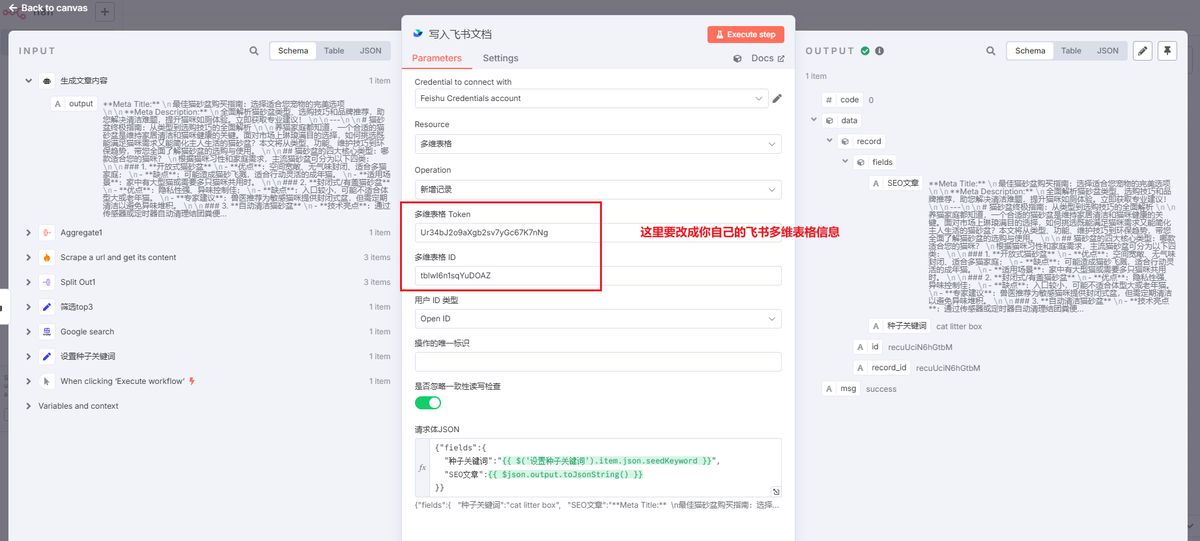

节点 9:写入飞书文档 (Feishu)

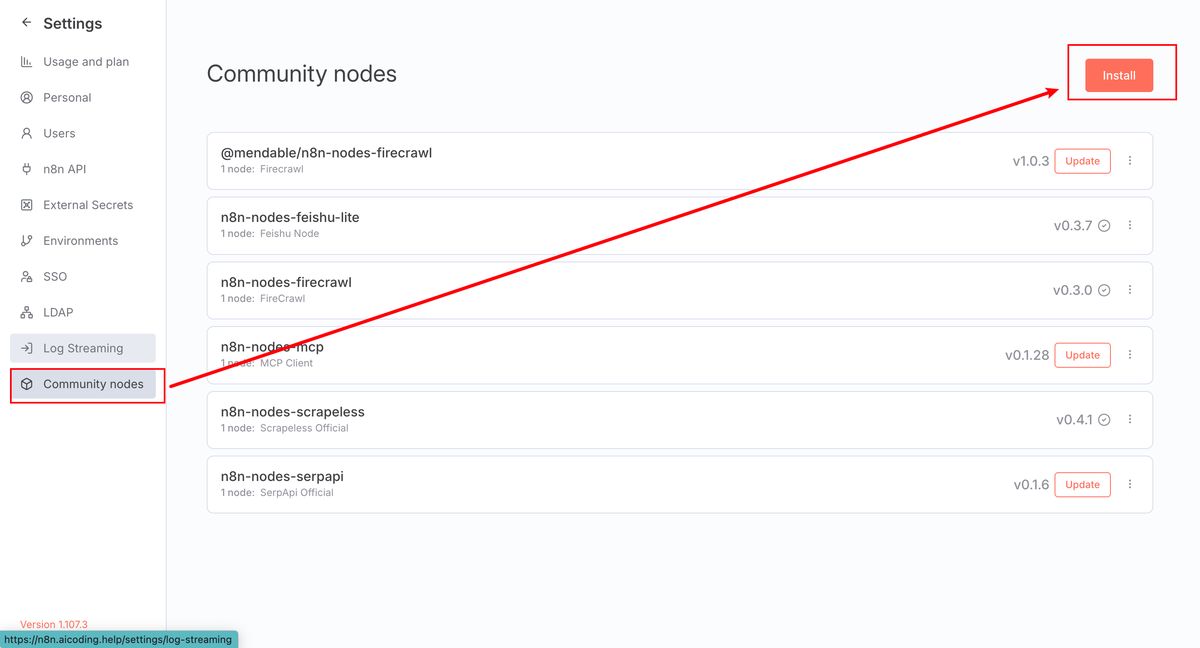

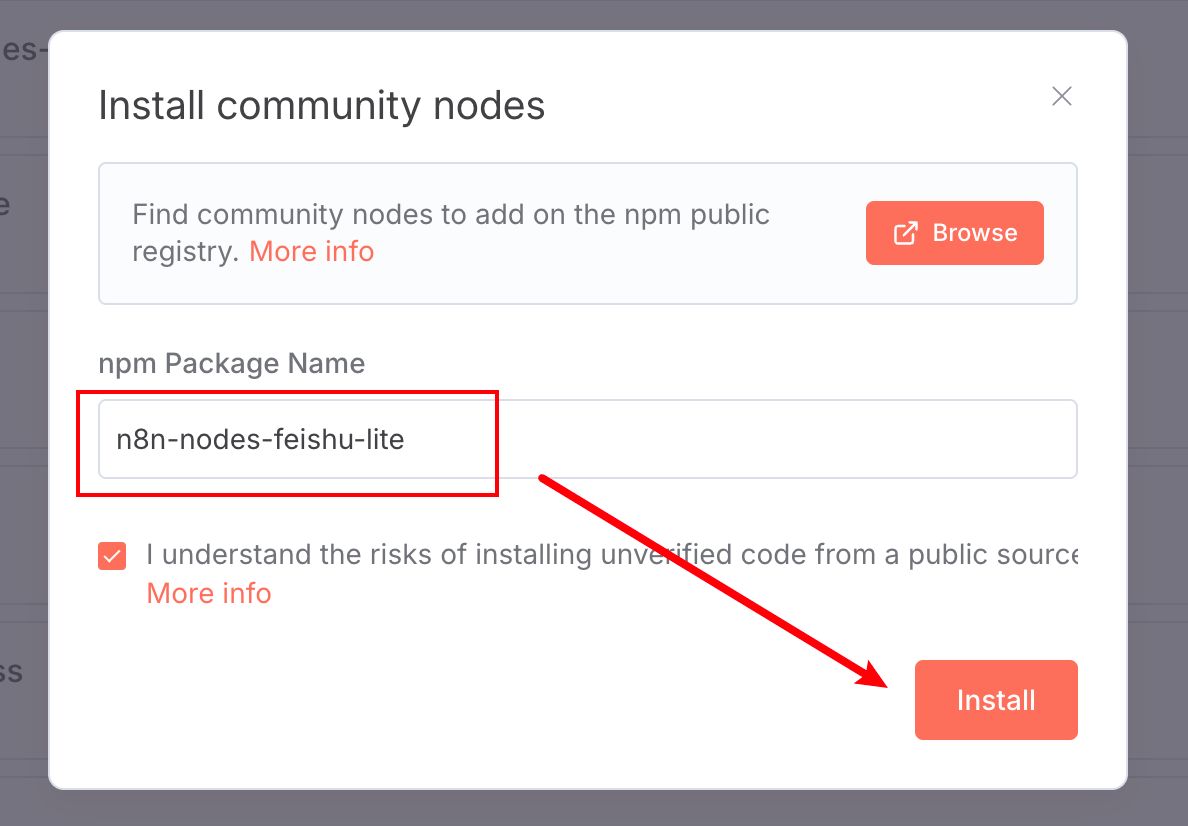

用飞书文档的话,需要提前先安装一个社区节点,体验会更丝滑

社区节点的意思可以直接用其他人写好的一套请求服务,无需自己从 0 写 http 请求

优先,左下角头像位置点 Settings

找到 Community nodes,点 install

如图,输入 n8n-nodes-feishu-lite,点安装即可。

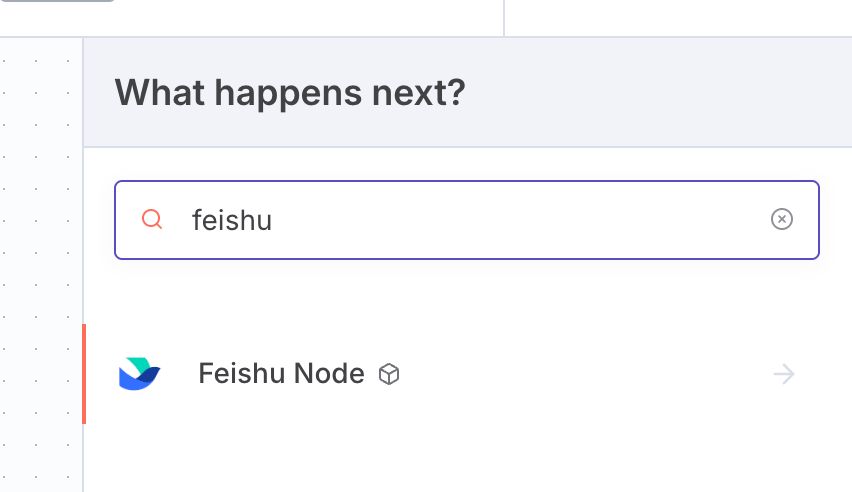

此时,我们再找 feishu(注意一定是英语)的时候,就会出现飞书的节点

可谓是非常齐全了,这里我们直接选多维表格的新增记录就好了。

接下来就可以去做配置。

-

作用:将 AI 生成的文章存入飞书多维表格。这便于内容团队后续使用,或通过 API 直接发布到网站。

-

配置:

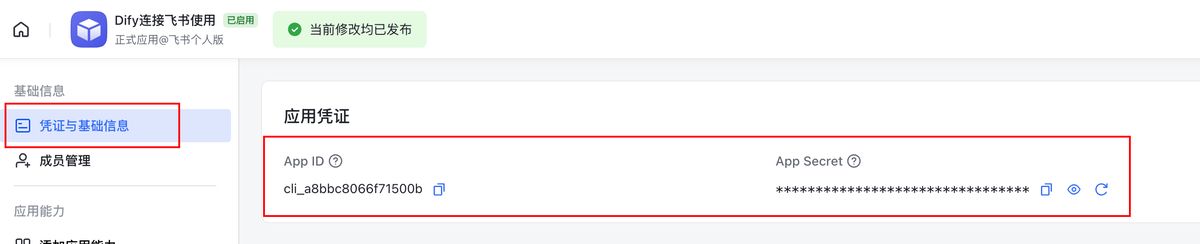

- Credentials: 设置你的飞书凭证,这里是要把飞书应用的

Appid和AppSecret填入

- Credentials: 设置你的飞书凭证,这里是要把飞书应用的

具体的权限配置见文末的**《番外:飞书权限设置》**

{"fields":{

"种子关键词":"{{ $('设置种子关键词').item.json.seedKeyword }}",

"SEO文章":{{ $json.output.toJsonString() }}

}}

此配置将“种子关键词”和 AI 生成的完整文章内容(output)分别存入表格中对应的字段。

至此,整个自动化“SEO 内容引擎”搭建完成。现在,你只需在“设置种子关键词”节点中输入关键词并执行工作流,一篇经过竞品分析后生成的 SEO 文章就会自动出现在你的飞书表格中。

这个工作流可以节省大量手动研究和写作的时间,使你能够规模化地生产高质量内容,并在搜索引擎优化方面获得优势。

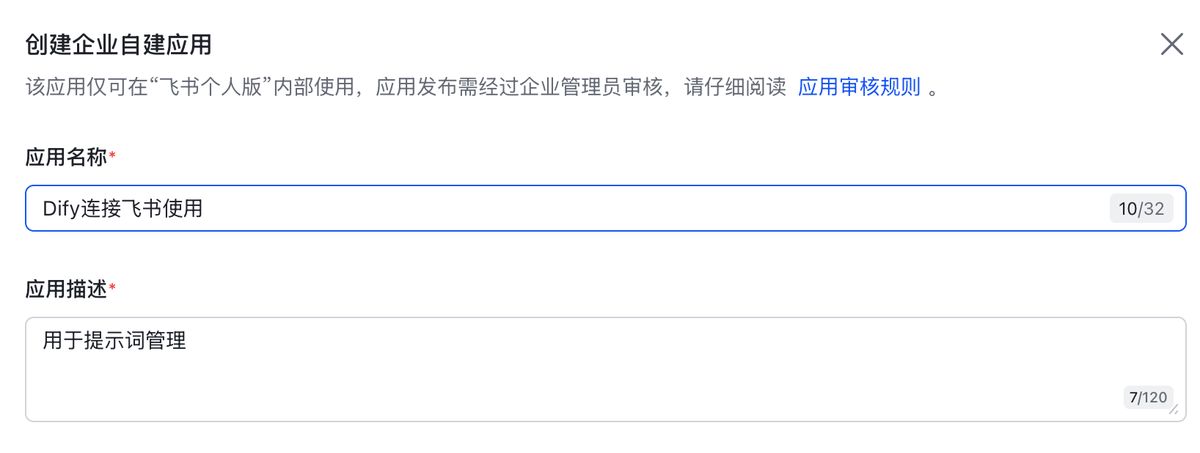

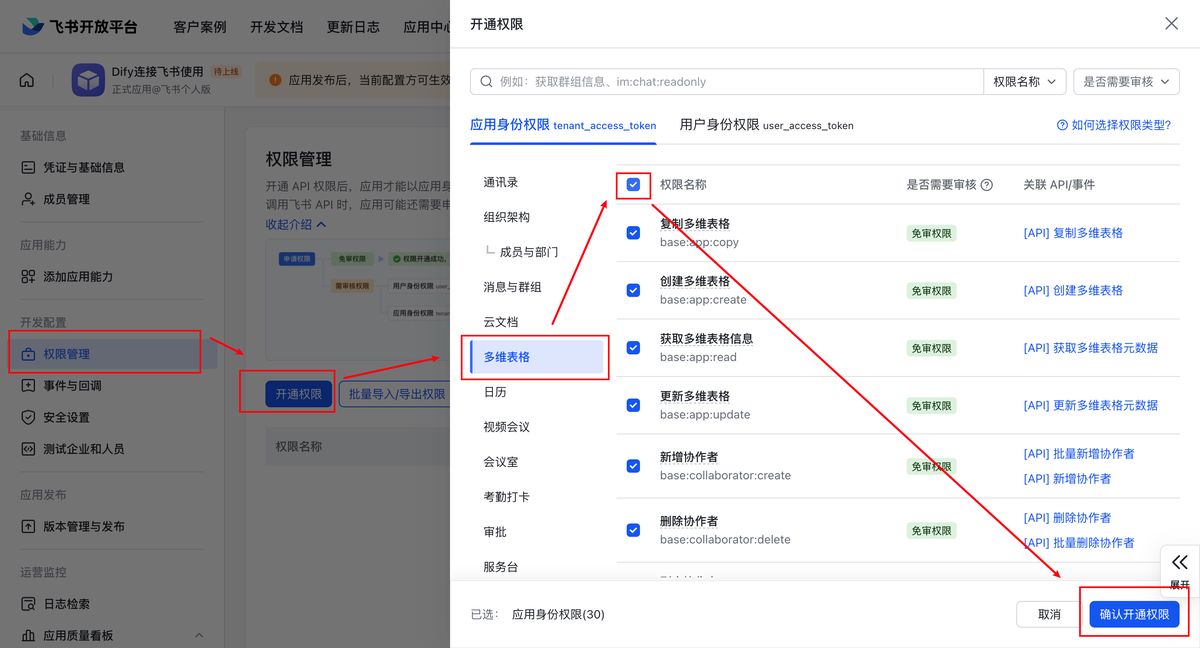

番外:飞书权限设置

首先,新建飞书应用,获取读写权限

进入飞书开发者后台 https://open.feishu.cn/

点「创建企业自建应用」

随便填应用的信息,然后点「创建」

如图操作,直接把多维表格的全部权限打开。

在「应用能力」这里,添加一个「机器人」的能力

点顶部的「创建版本」,随意填写版本详情,然后点「保存」-「确认发布」

发布后,新建一个群聊,把我们刚新建好的应用机器人拉到群里

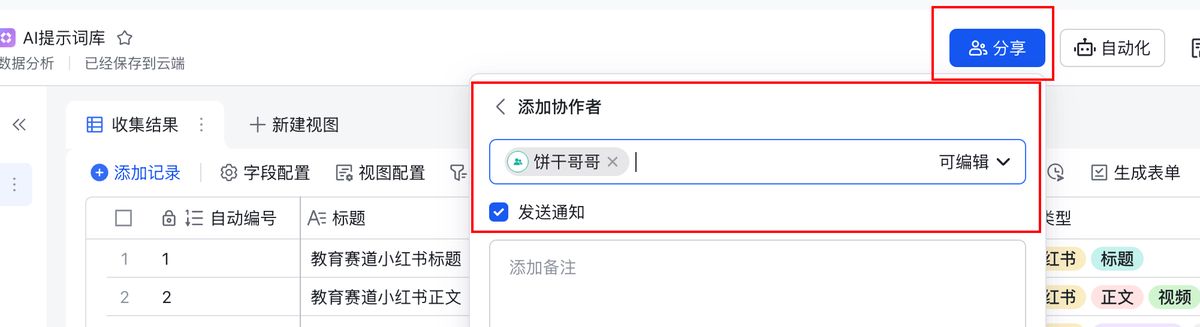

回到多维表格,把刚才新建的群聊添加协作者,并且开通「可编辑」权限

最后,回到飞书创作者后台,在「凭证与基础信息」的位置,拿到**「App ID」「App Secret」即可**

源文档:

进阶:我用 n8n 搭了个「Reddit 商机雷达」,AI 自动挖掘被忽略的真实需求,7×24 小时不错过任何风口

如果你是创业者或独立开发者,尤其是刚起步,最大的难题往往不是技术,而是“我到底该做什么?” 你有能力创造,却缺少一个真实、有人愿意付费解决的问题。

而如果你是做出海业务的市场人,需要找到下一个增长点:用户真正渴望的功能是什么?哪个细分市场的抱怨声最大?

这些困境,都源于我们离用户真实、一手的对话太远了。

今天,饼干哥哥就手把手带你用 n8n,从 0 到 1 搭建一个全自动的“Reddit 商机发现 AI Agent”。这套系统能不知疲倦地监控 Reddit 特定社区,自动筛选有价值的帖子,通过多维度 AI 分析,最终将一份份“商业机会简报”存入你的数据库,甚至直接发送到你的邮箱。

之前我们已经做过 1 期 n8n+reddit 的玩法——基于已知需求,用关键词去搜相关内容的:出海赚美金:用 n8n 搭建「Reddit 商机搜索与洞察」 AI Agent 自动化寻找蓝海市场,发现真实痛点;

而今天这期做的是** 未知需求,从 0 去发现用户痛点,提炼商机的。**

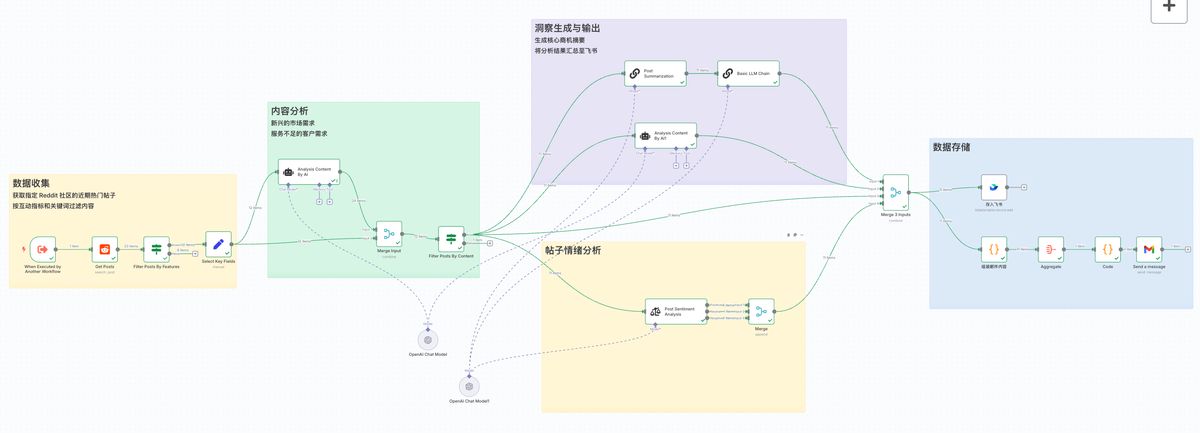

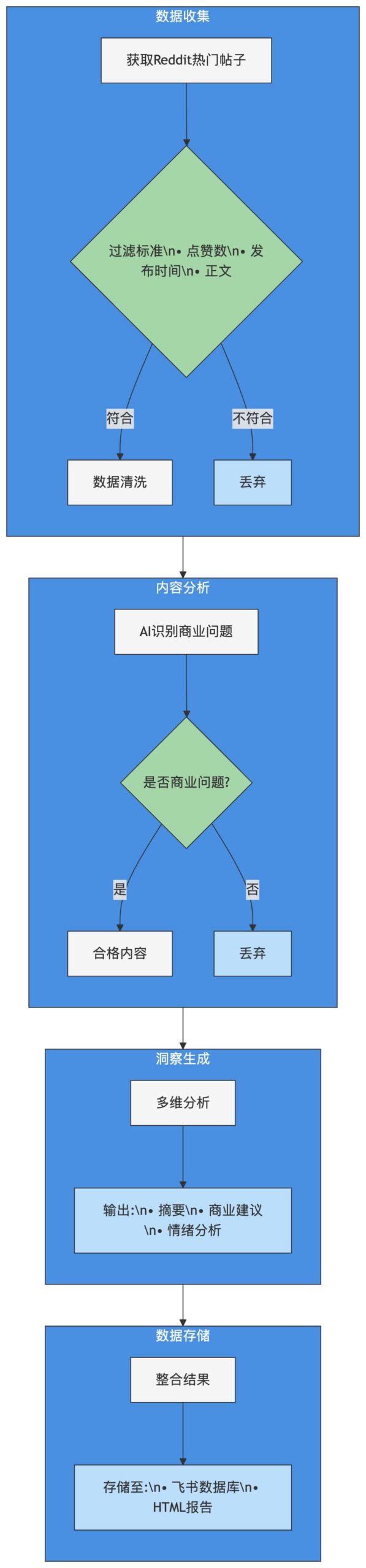

下图就是我们最终要搭建的自动化工作流,分为了四个核心阶段:数据收集、内容分析、洞察生成和数据存储。

这套系统不仅看起来很酷,更重要的是,它背后有一套严谨的、可落地的商业洞察逻辑。

一、一个好的商机发现框架是什么样的?

在进入 n8n 的节点配置前,我们必须先搞清楚这套打法背后的核心逻辑。为什么这套流程是科学的?它解决了传统市场调研的哪些核心痛点?

传统的市场调研方式(人工挖掘模式)

通常,一个标准的市场调研流程是这样的:

-

逛论坛:运营同学或产品经理打开 Reddit,进入 r/smallbusiness 或 r/SideProject 等社区,凭直觉一篇篇地刷帖子。

-

找痛点:看到某个帖子似乎在抱怨什么问题,就点进去看评论,试图从七嘴八舌的讨论中总结出核心需求。

-

记笔记:把有价值的帖子链接、内容要点复制粘贴到文档或表格里。

-

靠灵感:积累了一堆零散的笔记后,等待灵感迸发的那一刻。

这个流程最大的痛点是什么?三个字:低效、随机、主观。

你可能花了一下午,只看了几十个帖子,其中大部分还是无关的闲聊。你觉得某个痛点很重要,可能只是因为发帖人的文笔特别有感染力。这种方式极度依赖人的精力和判断力,无法规模化,更无法保证客观。

AI 工作流解决方案

我们的“Reddit 商机雷达”,就是为了解决这些痛点而设计的。它的核心思想,是把重复性的筛选、阅读、分析工作,全部交给 AI 和自动化工具,让人只专注于最终的决策。

我把它总结成了一个四步走的框架:

接下来,让我们进入实操环节,看看这个工作流在 n8n 里是如何一步步搭建起来的。

二、保姆级教程:从 0 到 1 搭建「Reddit 商机雷达」

为了方便理解,我们会逐一拆解工作流的每个阶段。

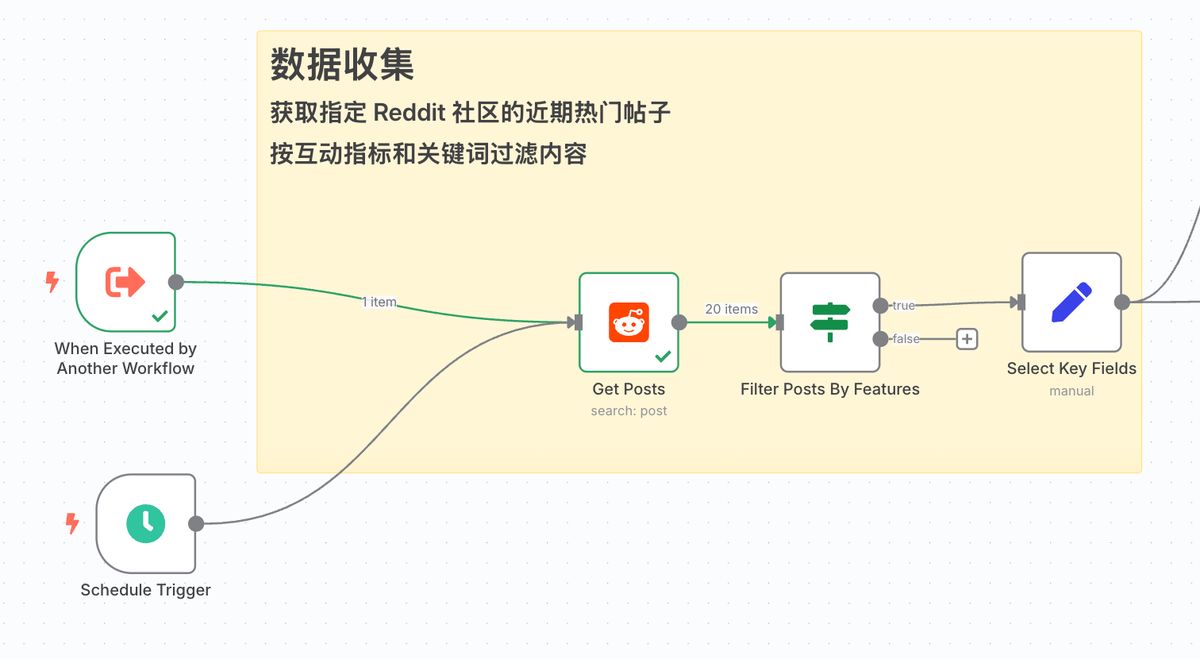

阶段一:数据收集

这个阶段的目标是,从 Reddit 海量的帖子中,自动筛选出那一小撮最有潜力的“金矿石”。

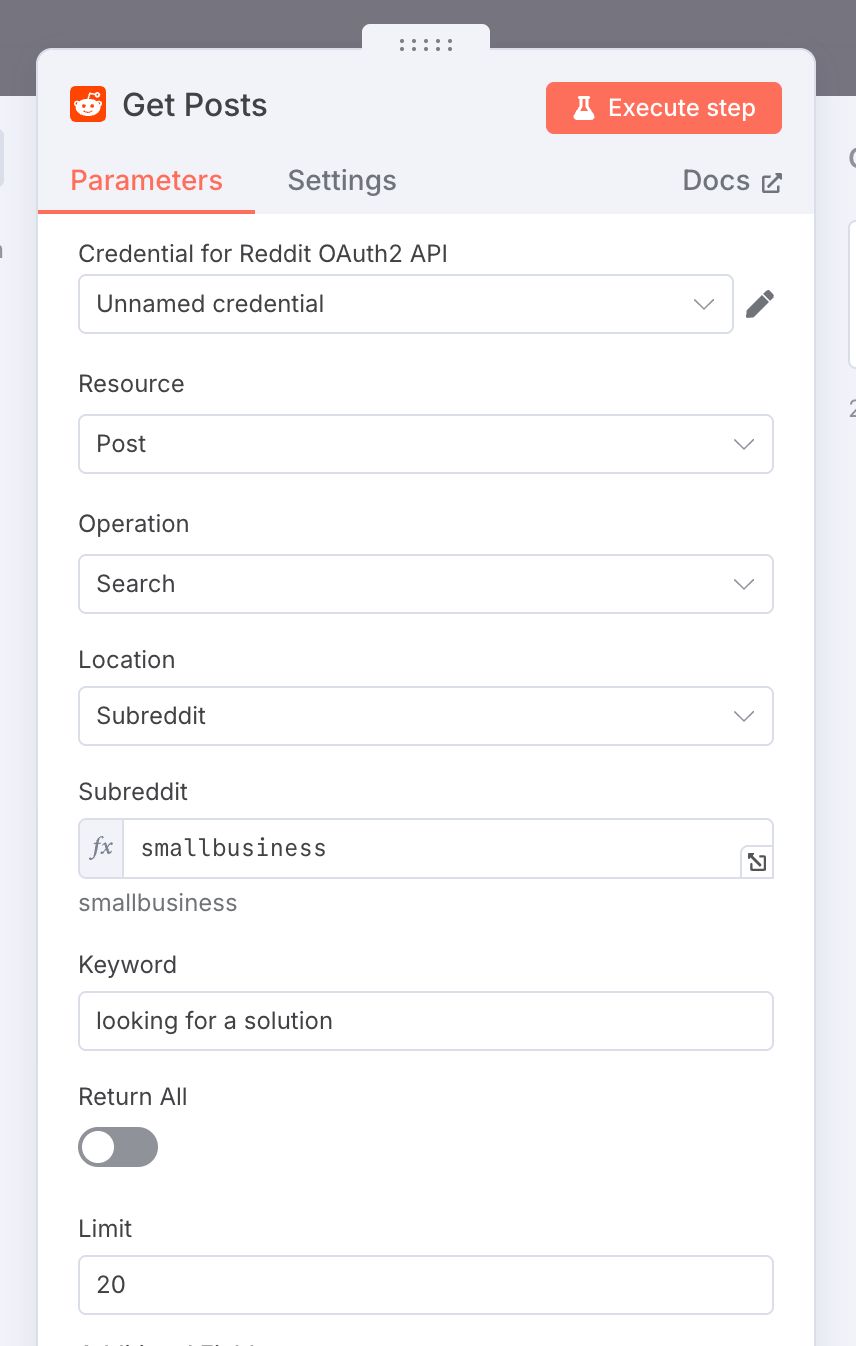

- 节点:Get Posts (Reddit)

-

作用:这是我们整个工作流的数据源。它负责到指定的 Reddit 子版块(Subreddit)中,根据关键词获取帖子。

-

配置:你需要先配置好 Reddit 的 API 凭证。然后设置要搜索的

Subreddit(如smallbusiness)和Keyword(如looking for a solution),并设置Limit(如 20 篇)来控制获取数量。

具体配置可以参考这篇文章来完成:出海赚美金:用 n8n 搭建「Reddit 商机搜索与洞察」 AI Agent 自动化寻找蓝海市场,发现真实痛点

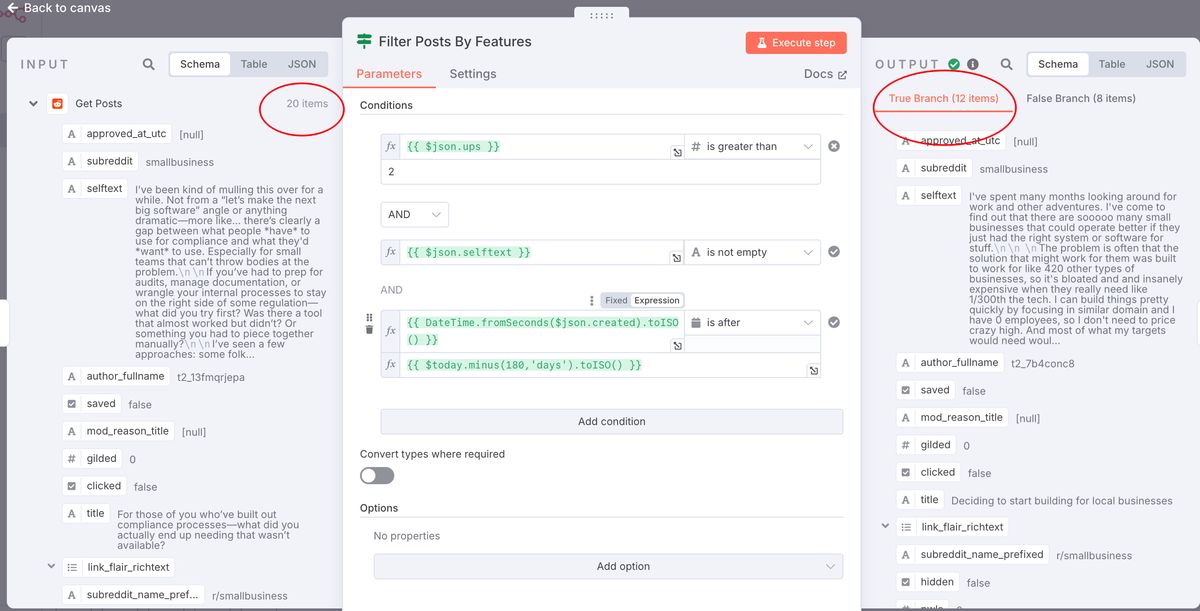

- 节点:Filter Posts By Features (IF)

- 作用:不是所有帖子都有分析价值。这个节点像一个保安,根据我们设定的硬性指标进行第一轮筛选。

- 配置:我们设置了三个条件:

- 点赞数

ups> 2 (有一定热度) - 帖子正文

selftext不为空 (有实质内容可分析) - 创建时间

created在最近 180 天内 (保证时效性)

- 点赞数

可以看到,节点从 20 个 Reddit 帖子中筛选出了 12 个符合 硬性要求 的信息。

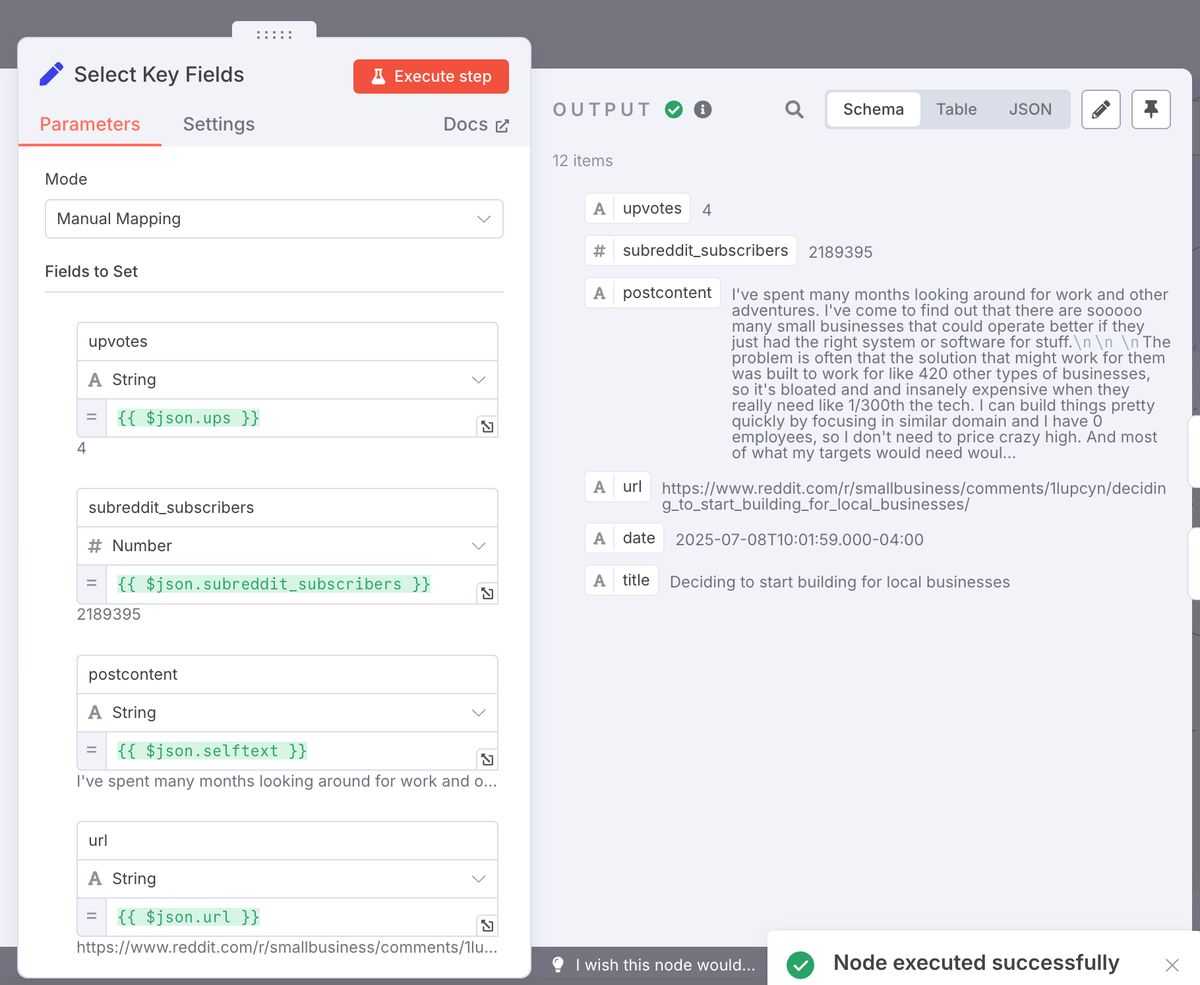

- 节点:Select Key Fields (Set)

- 作用:Reddit 返回的数据字段很多,我们只保留需要的,并对一些字段进行格式化,方便后续处理。比如,将 Unix 时间戳转换为标准日期格式。

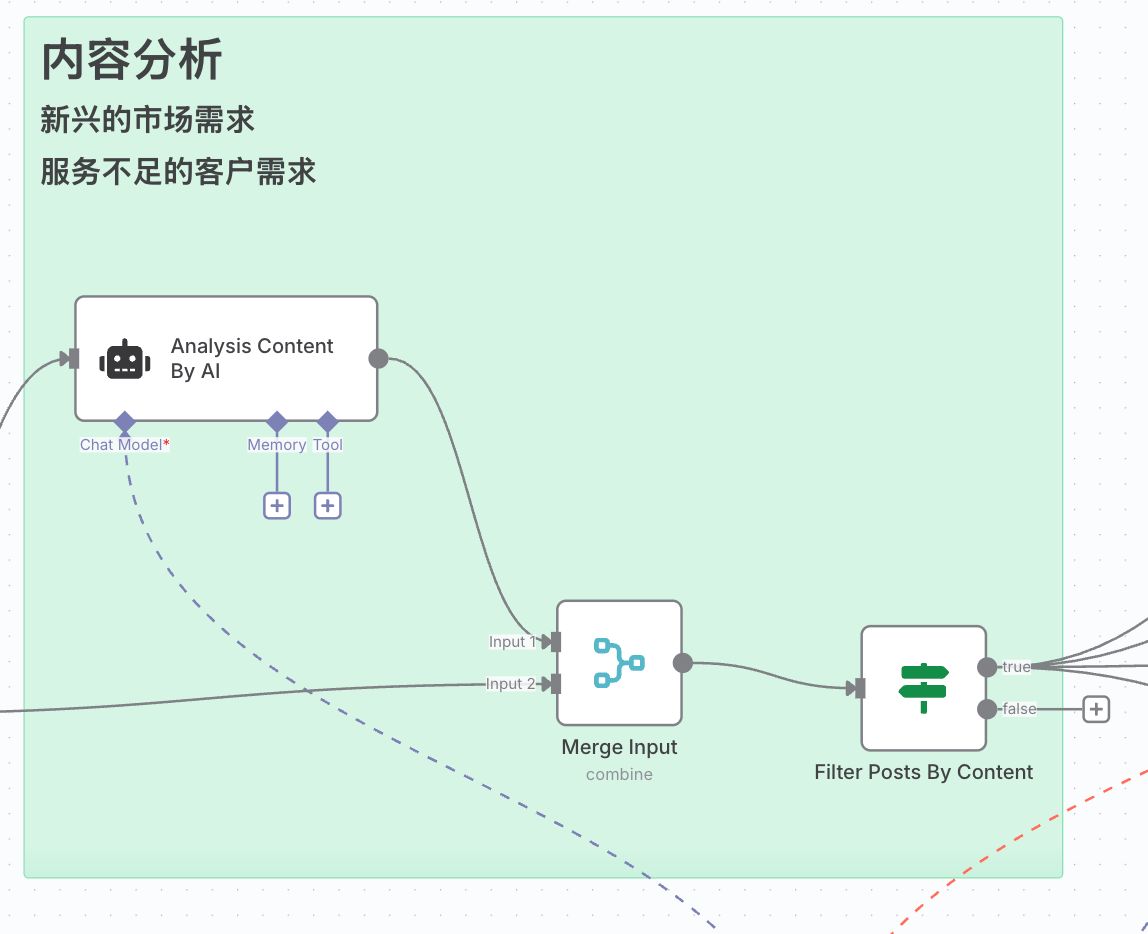

阶段二:内容分析 (AI 初筛,去伪存真)

这个阶段,我们引入第一个 AI,对内容进行初步的定性分析,判断它是否值得我们投入更多 AI 算力去深度挖掘。

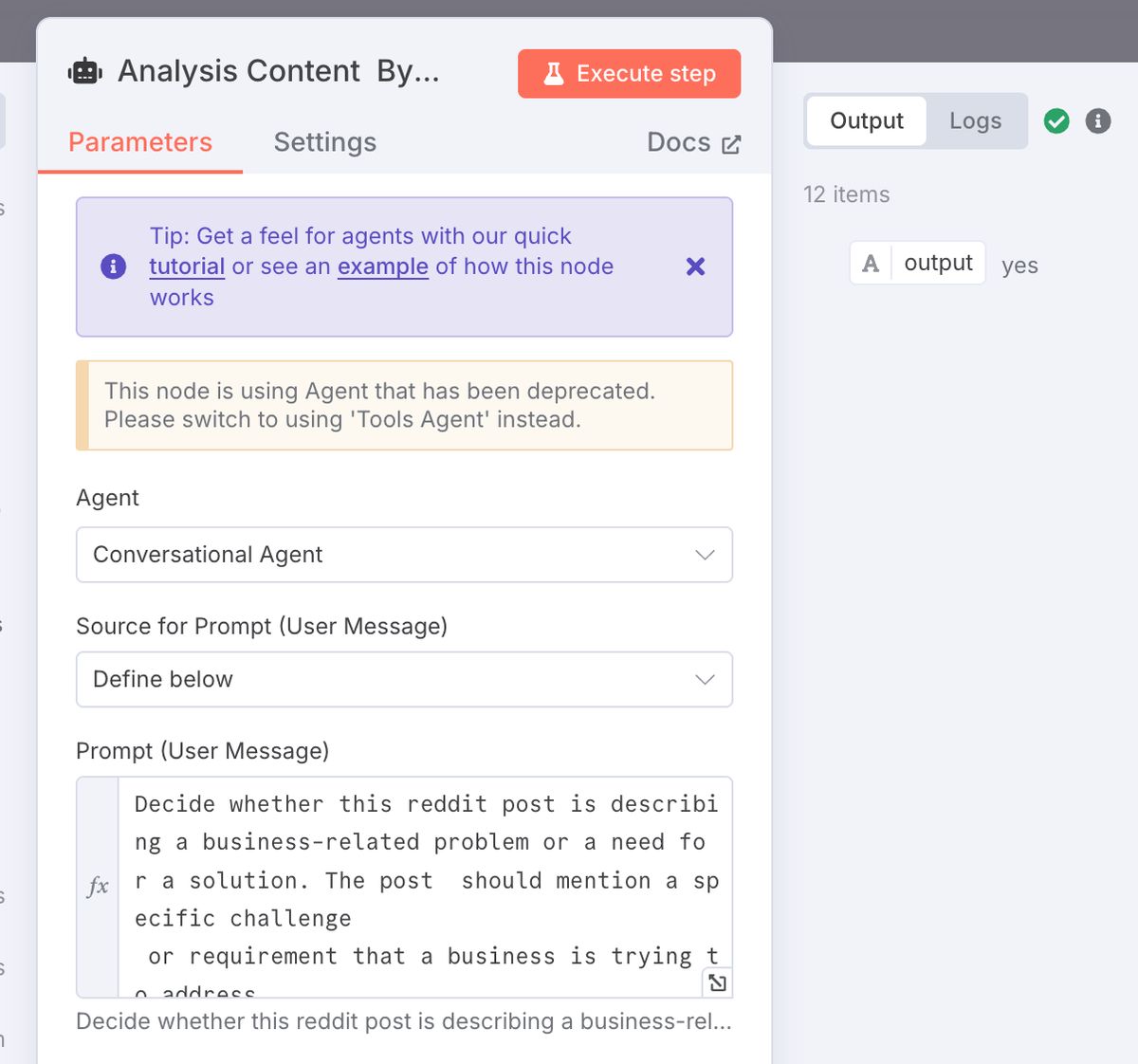

- 节点:Analysis Content By AI (Agent)

- 作用:AI 扮演“问题鉴别员”的角色。它会阅读每个帖子的内容,判断这篇帖子是否在描述一个商业相关的问题或需求。

- 配置:核心在于 Prompt:

Decide whether this reddit post is describing a business-related problem or a need for a solution. The post should mention a specific challenge or requirement that a business is trying to address.

Reddit post: {{ $json.postcontent }}

Is this post about a business problem or need for a solution? Output only yes or no.

- 这个Prompt要求AI只输出“yes”或“no”,非常便于后续的自动化处理。

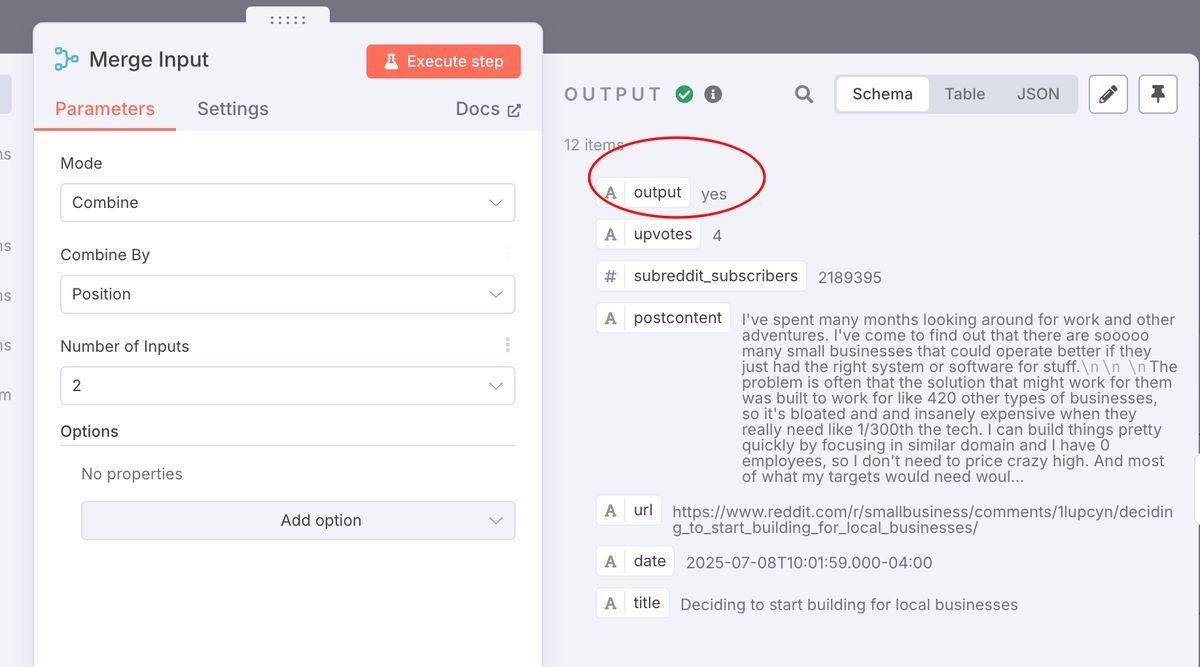

1. **节点:Merge Input**

- **作用**: 这是给原先 Reddit Posts的内容,加入是否为商业问题的`yes or no`的字段,用于后续的过滤

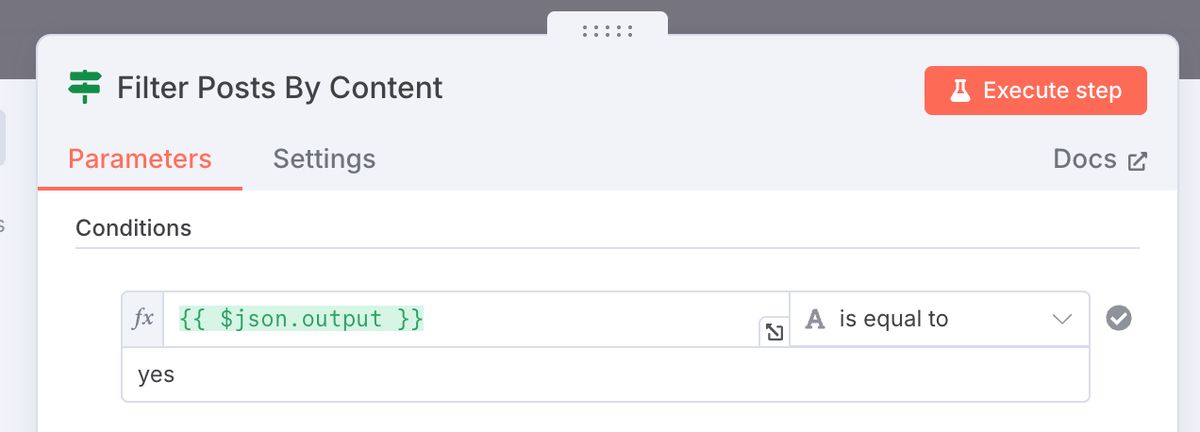

1. **节点:Filter Posts By Content (IF)**

- **作用**:又一个保安。这次它只放行被AI打上“yes”标签的帖子,那些闲聊、吐槽、不相关的帖子就被过滤掉了。

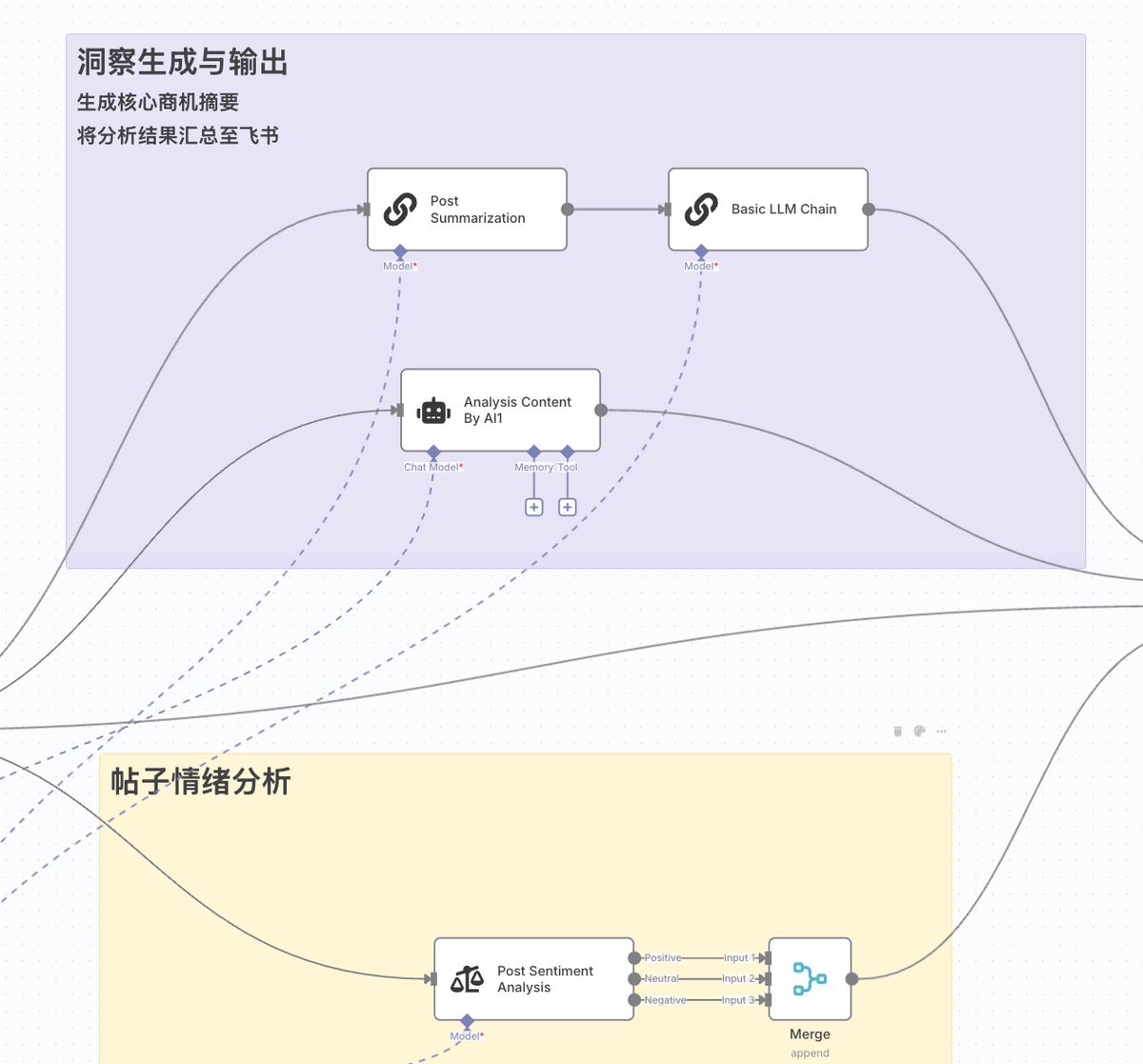

#### 阶段三:洞察生成与输出 (AI深度分析,炼石成金)

通过了前两轮筛选的帖子,可以说是“潜力股”了。现在,我们调动多个AI能力,对它们进行全方位的深度分析。

这一阶段,数据流会兵分三路,同时进行三种不同的分析:

1. **路径一:帖子摘要 (Post Summarization -> Basic LLM Chain)**

- **作用**:AI首先生成一个简短的帖子摘要,然后(如果需要)可以再通过一个LLM Chain节点将其翻译成中文,方便我们快速理解核心内容。

2. **路径二:商业点子生成 (Analysis Content By AI)**

- **作用**:让AI扮演“商业顾问”,根据帖子的内容,**直接提出一个可以解决该问题的商业点子或服务。**

- **提示词**:

```

Based on the following Reddit post, suggest a business idea or service that I could create to help this problem for this business and other with similar needs.

Reddit post: "{{ $json.postcontent }}"

Provide a concise description of a business idea or service that would adress this issue effectively for mutiple businesses facing similar challenges.

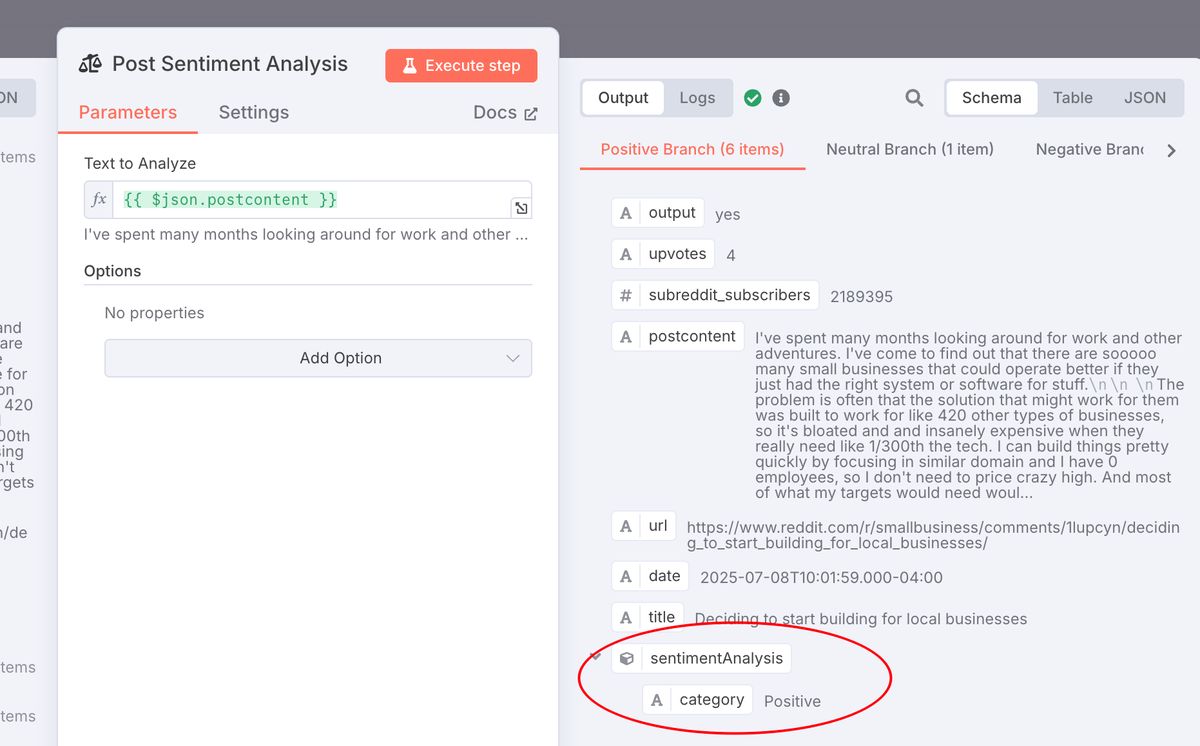

- 路径三:情绪分析 (Post Sentiment Analysis)

- 作用:用 AI 来判断一个帖子的作者是在表达积极的情绪(比如赞美、满意),还是消极的情绪(比如抱怨、愤怒、失望),或者是中性的情绪(比如陈述事实、提问)。这能帮我们判断用户是在热情地寻找方案,还是在痛苦地抱怨问题,不同的情绪可能对应不同的市场切入点。

这里补充讲一下:

这个节点的作用在于判断当前需求是否足够「痛」

你想想,一个商业机会往往源于一个未被解决的问题或一个强烈的痛点。而人们在什么时候会表达出最真实的痛点呢?—— 在他们抱怨的时候!

所以,这个节点能帮我们:

-

✅ 快速锁定“抱怨帖”:

- 如果一个帖子的情感分析结果是**“消极 (Negative)”** ,那它很可能就是一个金矿!比如一个用户发帖说:“我受够了现在用的 XX 软件,太难用了,有没有更好的推荐?” 这就是一个强烈的商业信号。这个帖子的“消极”情绪越强,说明用户的痛点越深,付费解决的意愿可能就越高。

-

识别“赞美帖”的价值:

- 如果一个帖子的情感分析结果是**“积极 (Positive)”** ,它同样有价值。这能告诉我们,现有的某个产品或解决方案,哪些地方做得特别好,深受用户喜爱。这对于我们做竞品分析,或者思考如何“做得更好”非常有帮助。

后续,我们可以增加一个过滤条件:优先分析那些**“情感为消极”且“点赞数很高”的帖子**。

这样的帖子几乎可以断定:这是一个很多人都感同身受的、亟待解决的普遍性问题。 —— 这不就是最好的商业机会吗?

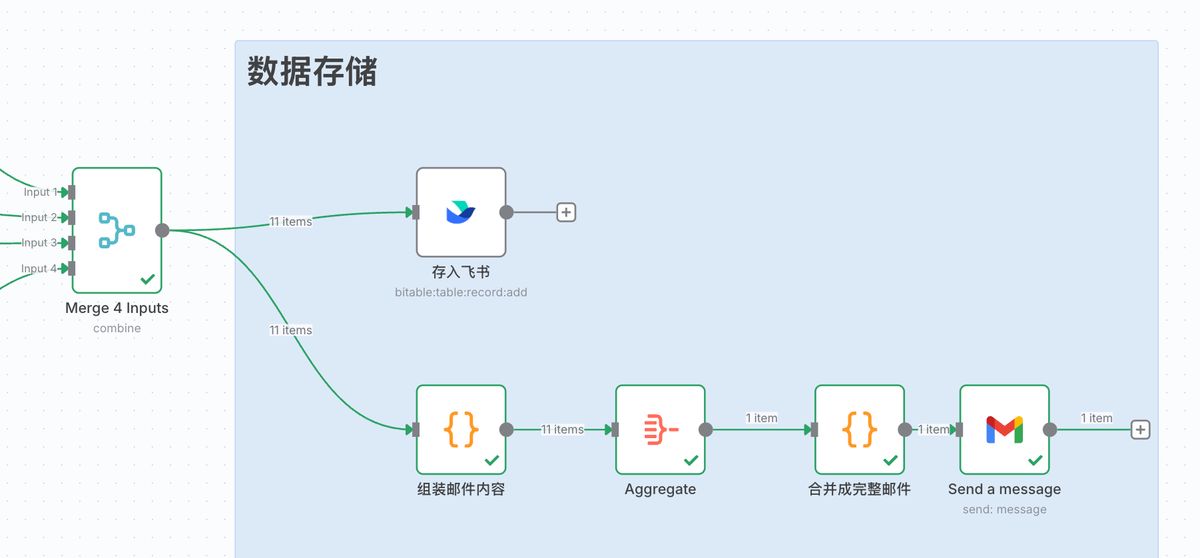

阶段四:数据存储与报告 (汇总成果,触手可及)

最后,我们将所有 AI 分析的结果汇总起来,以两种方式呈现给我们。

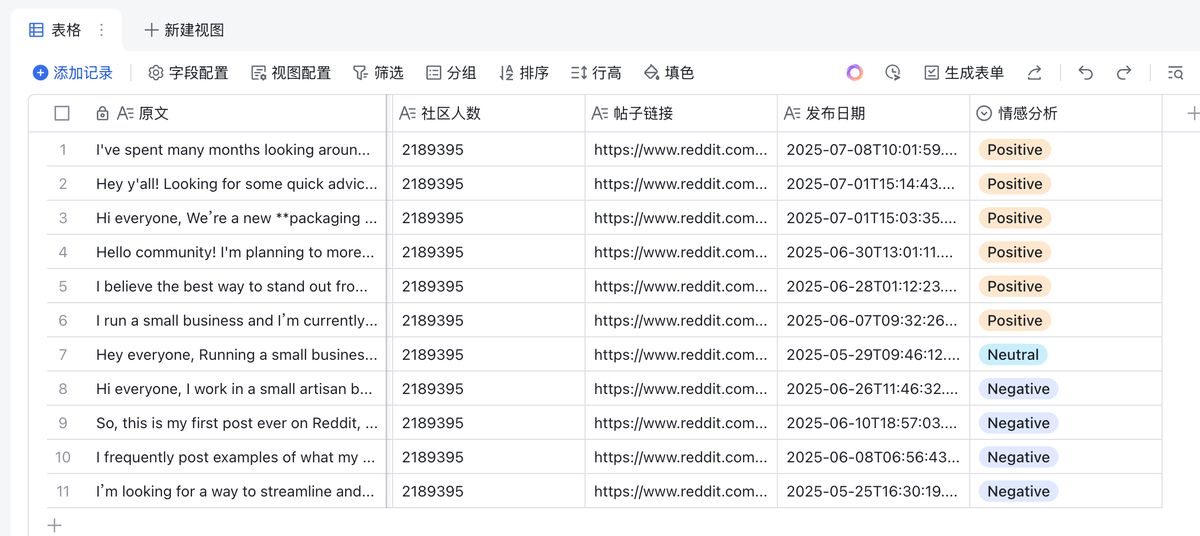

- 节点:存入飞书 (Feishu)

- 作用:将每一篇分析过的帖子的所有信息——原文链接、摘要、商业点子、情绪、点赞数等,结构化地存入飞书多维表格。这个表格就成了我们动态更新的、永不枯竭的“商机库”。

其中,情绪分析的Negative就是用户抱怨的「痛点」

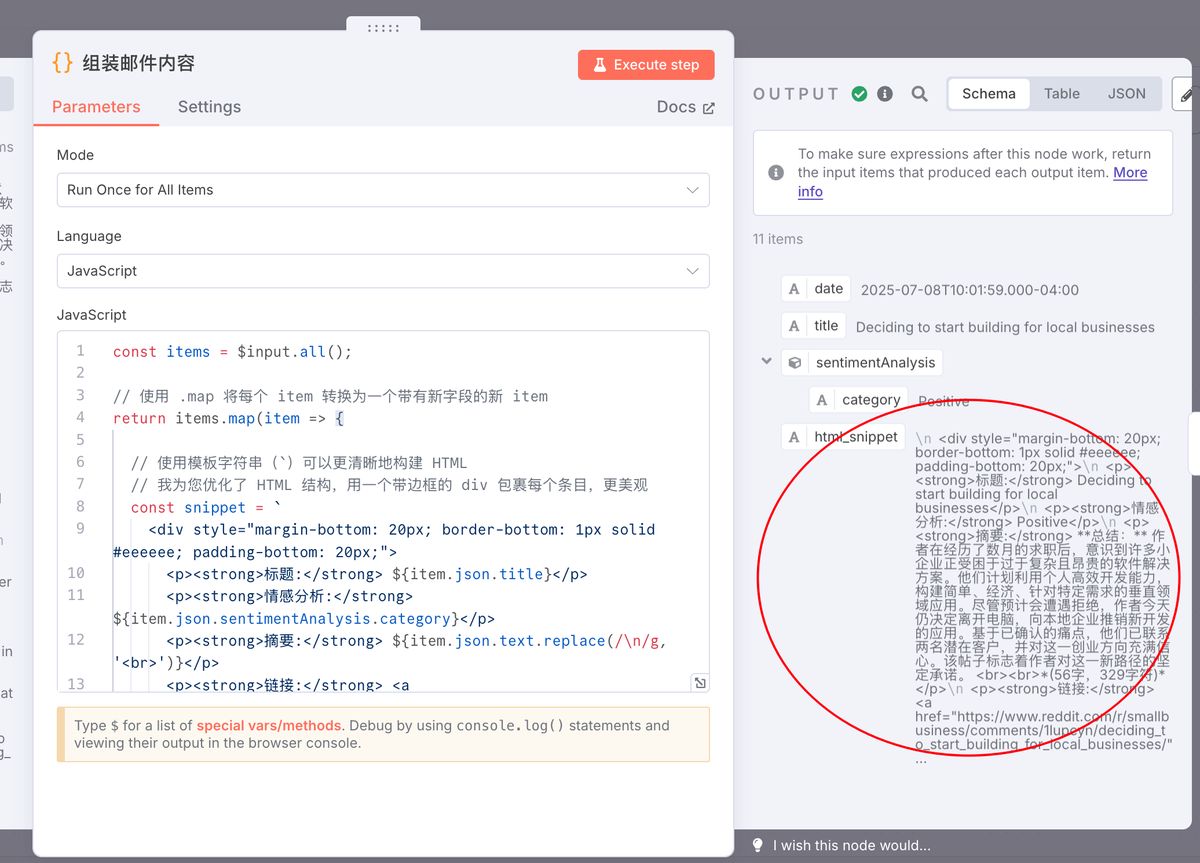

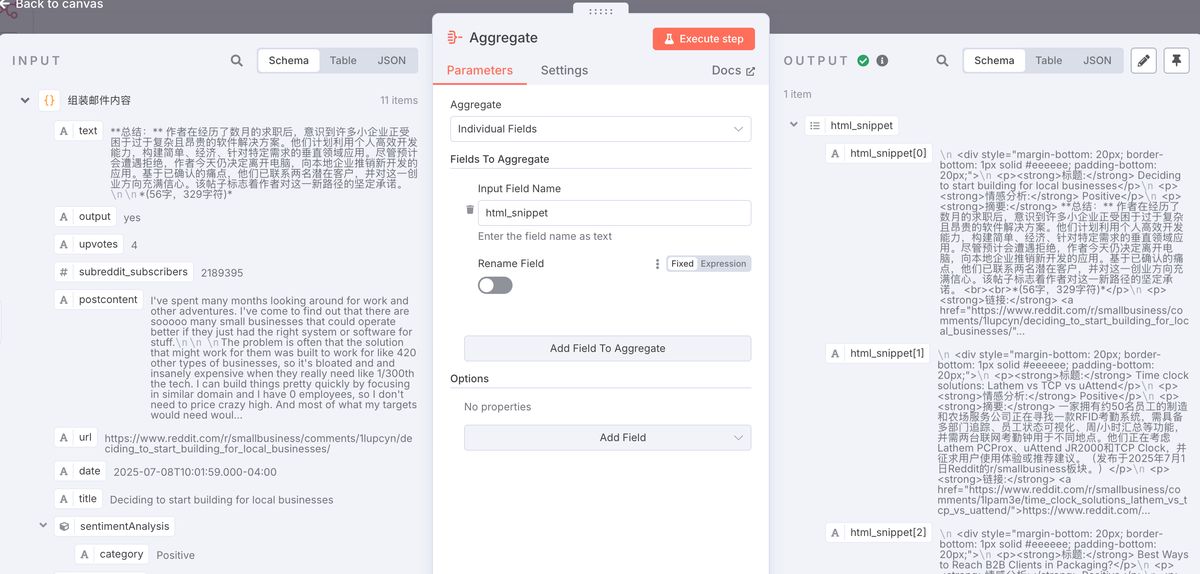

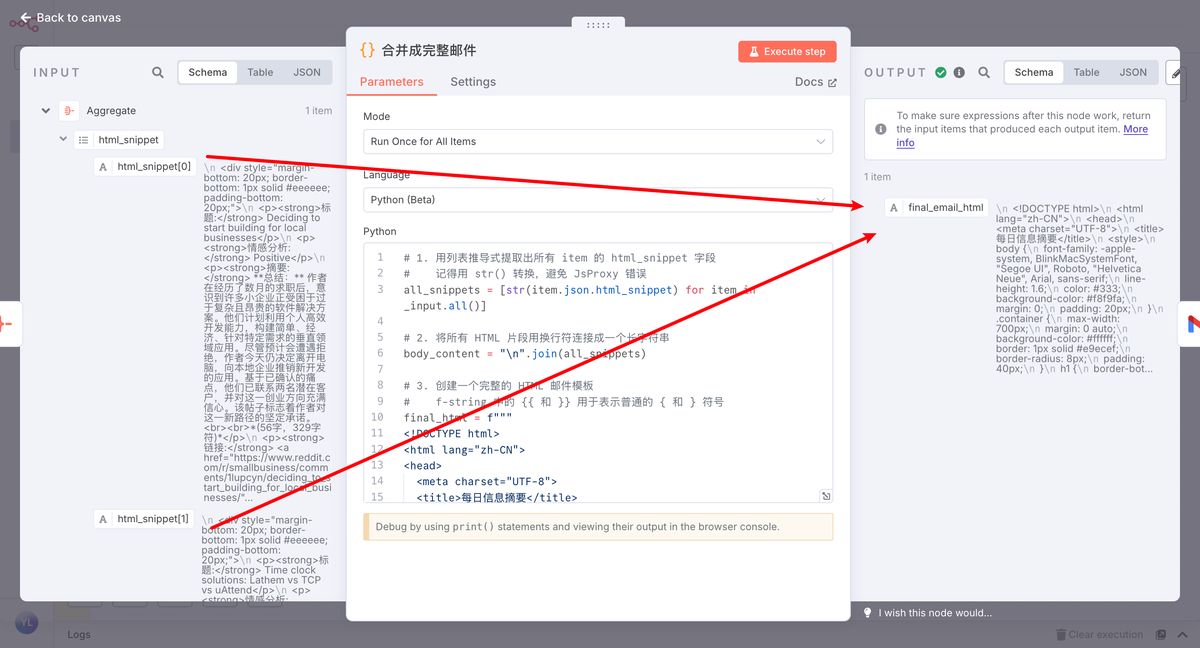

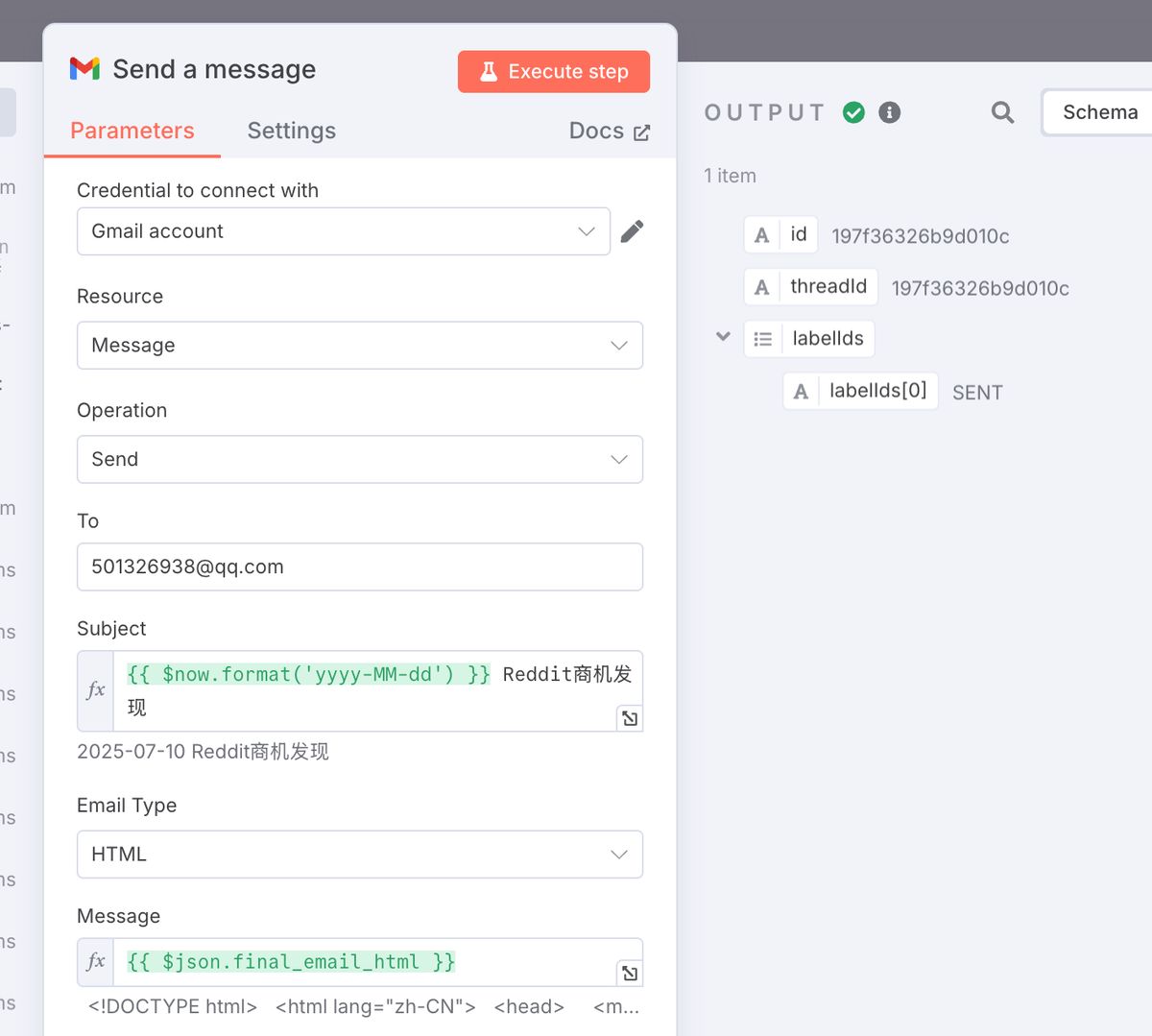

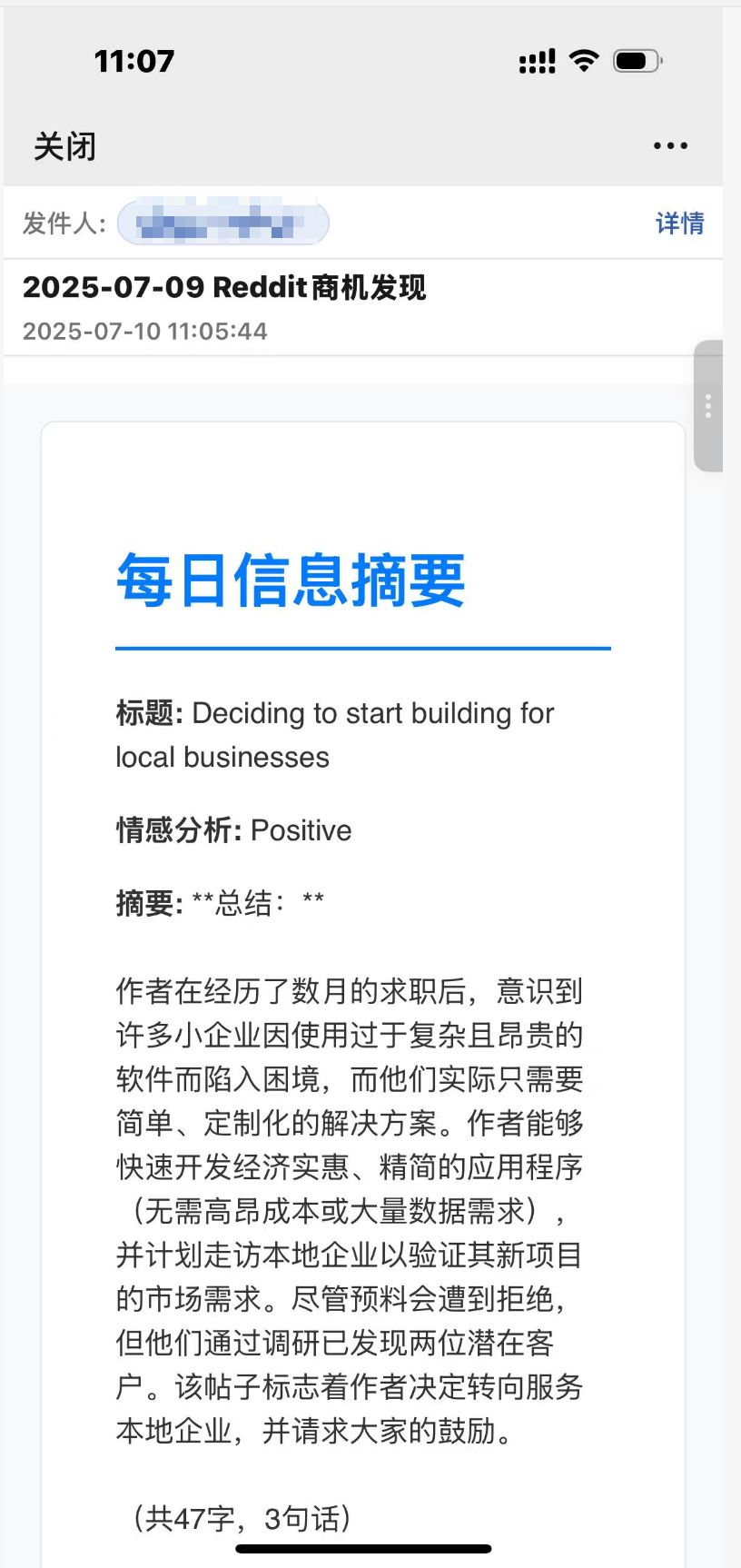

- 节点:发送邮件报告 (Code -> Aggregate -> Send a message)

- 作用:除了存入数据库,系统还会自动生成一封精美的 HTML 邮件,将当天的所有发现汇总起来,发送到你的邮箱。

- 流程:

组装邮件内容 (Code): 将每个帖子的分析结果,用 HTML 代码片段格式化。

Aggregate: 将所有 HTML 片段合并成一个完整的邮件正文。

Code: 用一个优雅的 HTML 模板包裹邮件正文,使其更美观。

Send a message: 发送最终的邮件。

这样,即使你不登录 n8n 或飞书,每天早上也能在邮箱里收到一份热气腾腾的“全球商机日报”,是不是很棒?

写在最后

今天我们分析的是商业机会,但这个方法论完全可以复用在任何你想打透的领域——无论是寻找产品改进点、挖掘内容营销选题,还是监控竞品动态。